版本1.7.3.RELEASE

©2012-2018 Pivotal Software,Inc。

本文档的副本可供您自己使用并分发给他人,前提是您不对此类副本收取任何费用,并且每份副本均包含本版权声明,无论是以印刷版还是电子版分发。

前言

1.关于文档

2.获得帮助

遇到Spring Cloud Data Flow问题,我们想帮忙!

-

问一个问题。我们监控stackoverflow.com以获取标记的问题

spring-cloud-dataflow。 -

在github.com/spring-cloud/spring-cloud-dataflow/issues上使用Spring Cloud Data Flow报告错误。

| 所有Spring Cloud Data Flow都是开源的,包括文档!如果您发现文档有问题,或者您只想改进它们,请参与其中。 |

入门

如果您开始使用Spring Cloud Data Flow,则本节适合您。在本节中,我们回答基本的“什么?”,“如何?”和“为什么?”的问题。您可以找到Spring Cloud Data Flow的简要介绍以及安装说明。然后,我们构建一个介绍性的Spring Cloud Data Flow应用程序,讨论一些核心原则。

3.系统要求

4. Docker Compose入门

从Spring Cloud Data Flow 1.4开始,提供Docker Compose文件以快速显示Spring Cloud Data Flow及其依赖项,而无需手动获取它们。运行时,组合系统包括Spring Cloud Data Flow本地服务器的最新GA版本,使用Kafka绑定器进行通信。Docker Compose是必需的,建议使用最新版本。

-

下载Spring Cloud Data Flow本地服务器Docker Compose文件:

$ wget https://raw.githubusercontent.com/spring-cloud/spring-cloud-dataflow/v1.7.3.RELEASE/spring-cloud-dataflow-server-local/docker-compose.yml

如果wget命令不可用,则可以使用curl或其他特定于平台的实用程序。或者导航到web中的https://raw.githubusercontent.com/spring-cloud/spring-cloud-dataflow/v1.7.3.RELEASE/spring-cloud-dataflow-server-local/docker-compose.yml浏览器并保存内容。确保下载的文件名为docker-compose.yml。

|

-

启动Docker Compose

在您下载

docker-compose.yml的目录中,启动系统,如下所示:$ export DATAFLOW_VERSION=1.7.3.RELEASE $ docker-compose updocker-compose.yml文件定义变量DATAFLOW_VERSION,以便可以轻松更改。上面的命令首先设置要在环境中使用的DATAFLOW_VERSION,然后启动docker-compose。只将

DATAFLOW_VERSION变量暴露给docker-compose进程而不是在环境中设置的简写版本如下:$ DATAFLOW_VERSION=1.7.3.RELEASE docker-compose up使用Windows时,使用

set命令定义环境变量。要在Windows上启动系统,请输入以下命令:C:\ set DATAFLOW_VERSION=1.7.3.RELEASE C:\ docker-compose up默认情况下,Docker Compose将使用本地可用的图像。例如,在使用 latest标记时,请在docker-compose up之前执行docker-compose pull以确保下载最新图像。 -

启动Spring Cloud Data Flow仪表板

docker-compose命令停止发出日志消息后,Spring Cloud Data Flow将可以使用。此时,在浏览器中导航到Spring Cloud Data Flow仪表板。默认情况下,将自动导入最新的GA版本的Stream和Task应用程序。 -

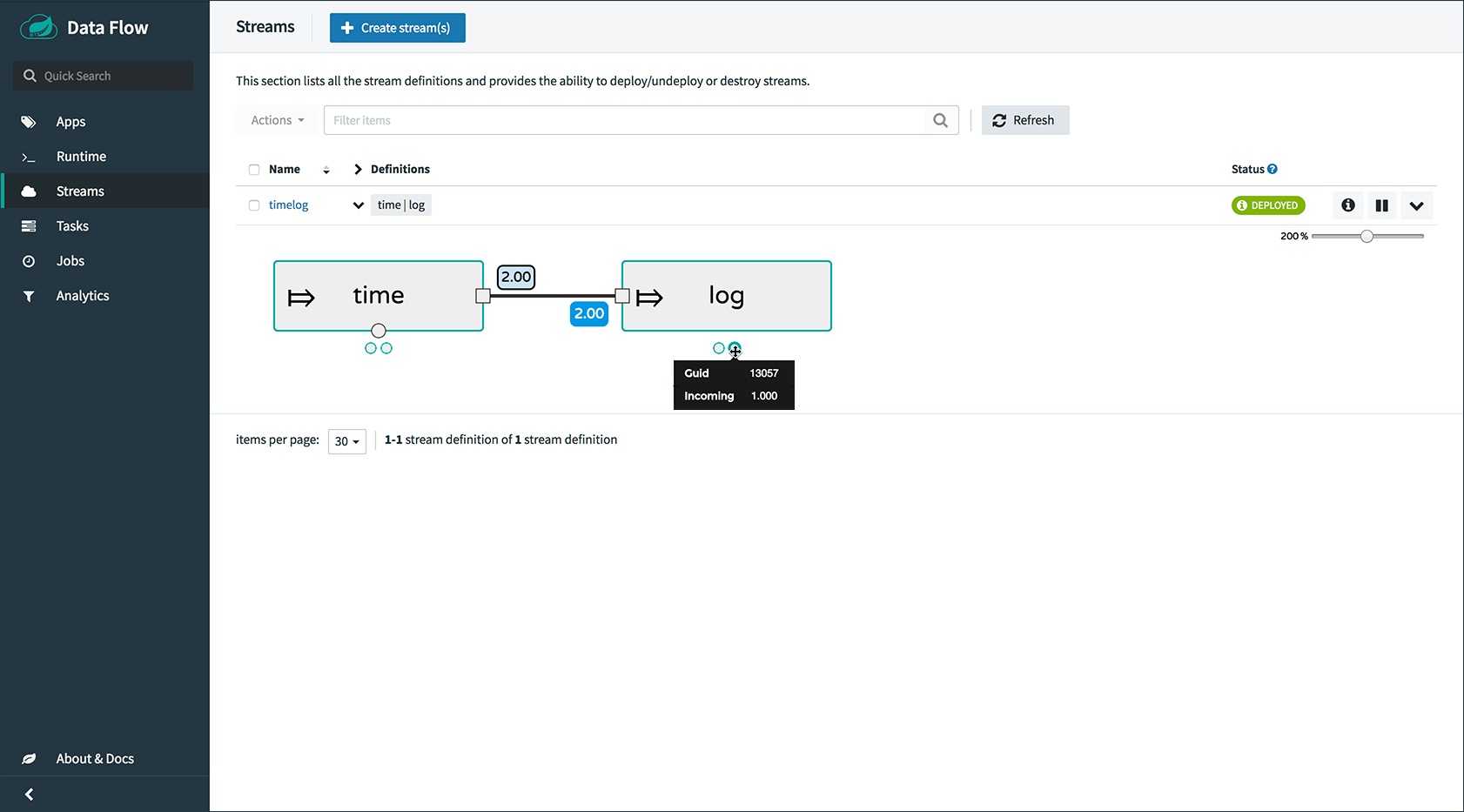

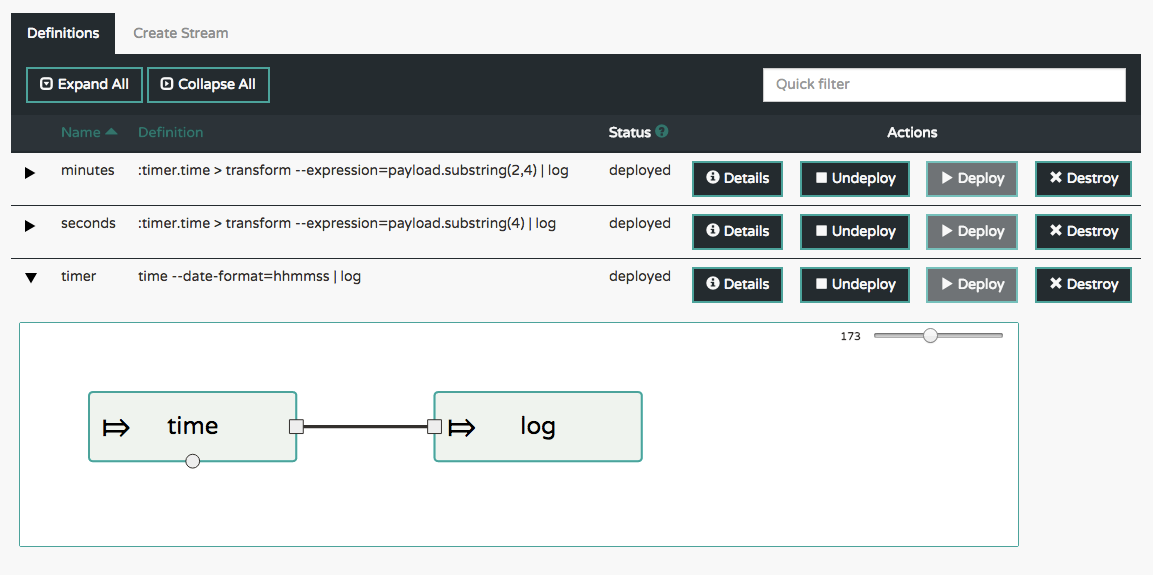

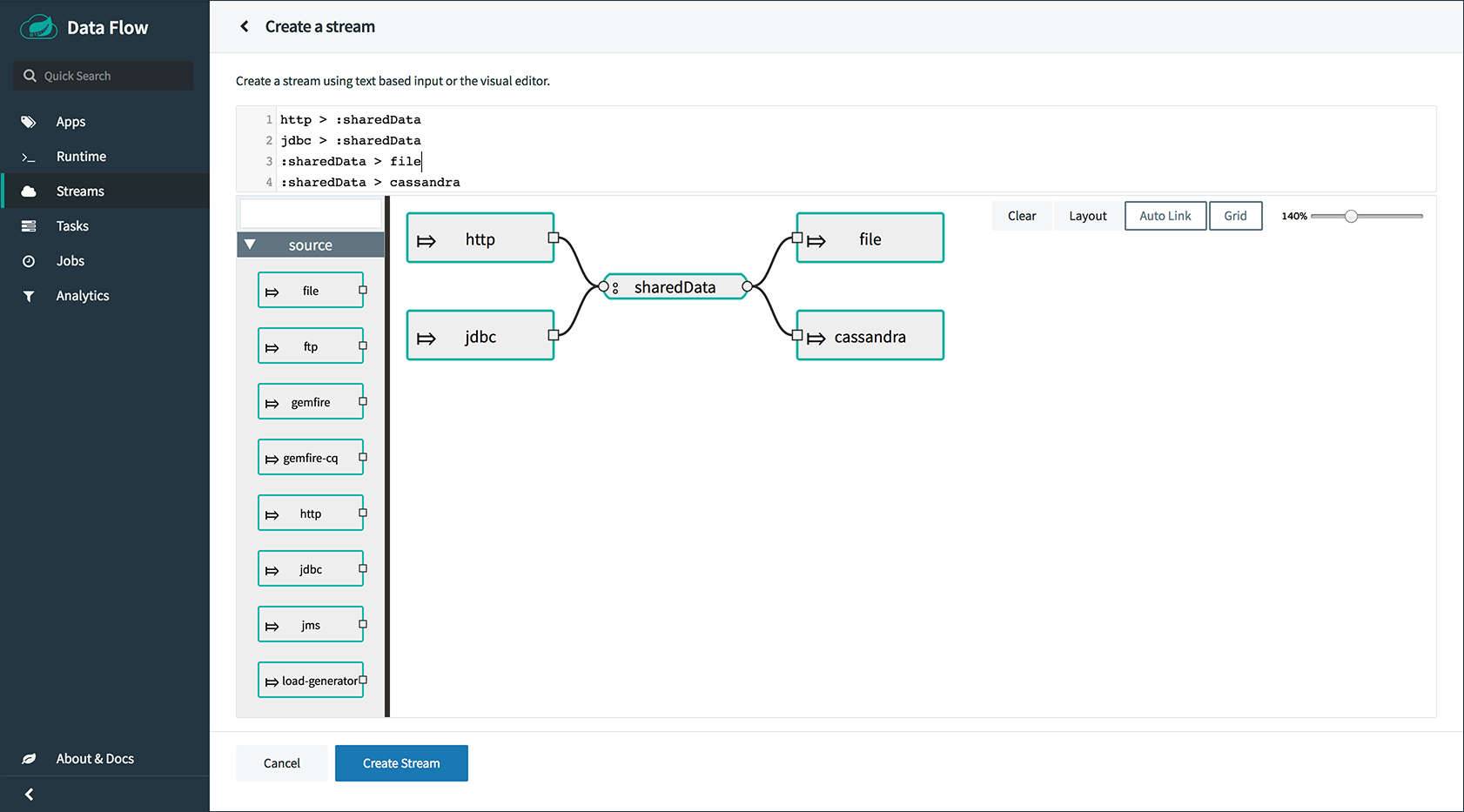

创建一个流

要创建流,首先导航到“Streams”菜单链接,然后单击“Create Stream”链接。在“Create Stream”textarea中输入

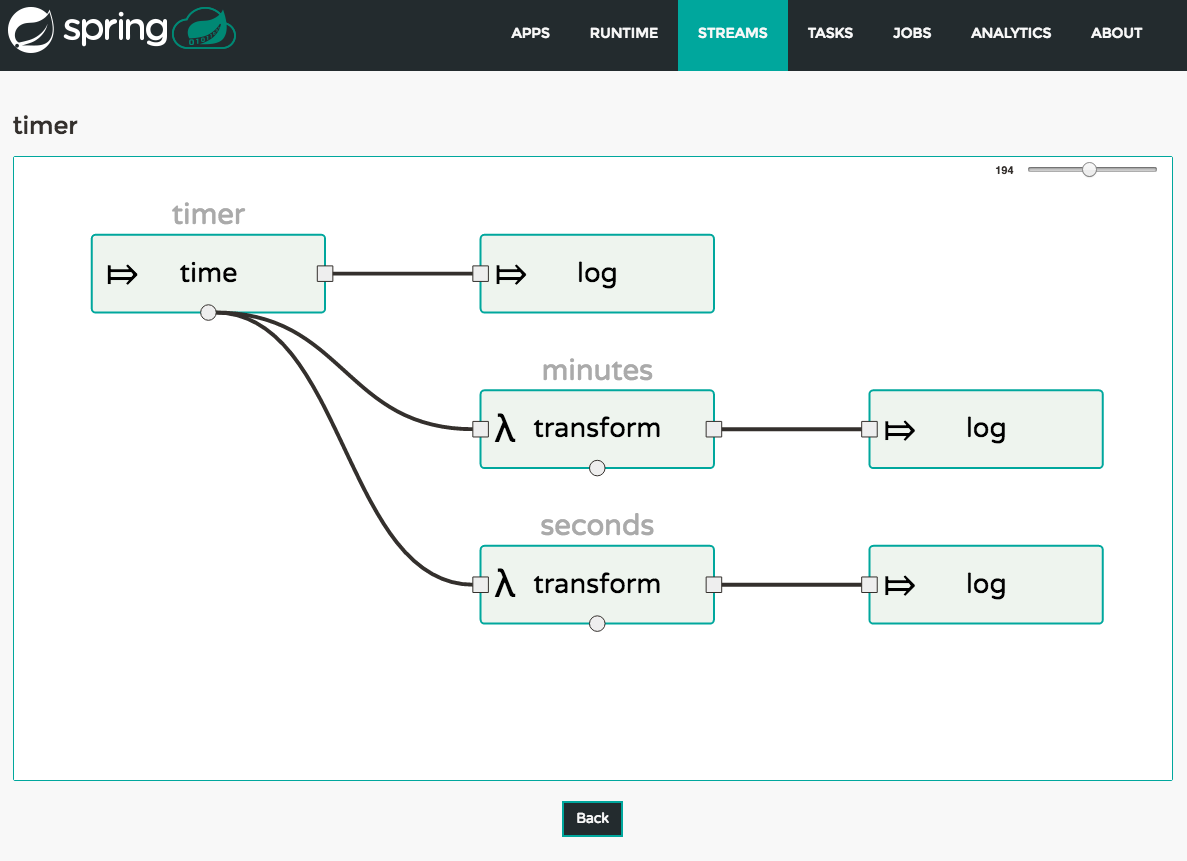

time | log,然后单击“CREATE STREAM”按钮。输入“ticktock”作为流名称,然后单击“Deploy Stream(s)”复选框,如下图所示: 图1.创建流

图1.创建流然后单击“确定”,它将返回到“定义”页面。流将处于“部署”状态,并在完成后移至“已部署”。您可能需要刷新浏览器才能看到更新后的状态。

-

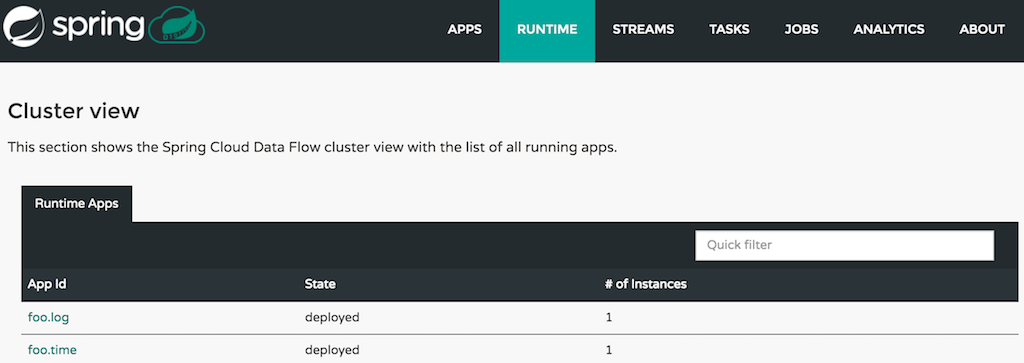

查看流日志

要查看流日志,请导航到“运行时”菜单链接,然后单击“ticktock.log”链接。复制仪表板上“stdout”文本框中的路径以及另一种控制台类型:

$ docker exec -it dataflow-server tail -f /path/from/stdout/textbox/in/dashboard您现在应该看到日志接收器的输出,每秒打印一次时间戳。按CTRL + c结束

tail。 -

删除流

要删除流,首先导航到仪表板中的“Streams”菜单链接,然后单击“ticktock”行上的复选框。单击“DESTROY ALL 1 SELECTED STREAMS”按钮,然后单击“YES”以销毁流。

-

销毁快速启动环境

要破坏快速启动环境,请在

docker-compose.yml所在的另一个控制台中键入如下内容:$ docker-compose down某些流应用程序可能会打开一个端口,例如 http --server.port=。默认情况下,端口范围9000-9010从容器暴露给主机。如果要更改此范围,请修改docker-compose.yml文件中dataflow-server服务的ports块。

4.1.Docker撰写自定义

开箱即用的Spring Cloud Data Flow将使用H2嵌入式数据库来存储状态,Kafka用于通信而不使用分析。可以通过编辑docker-compose.yml文件对这些组件进行自定义,如下所述。

-

要使用MySQL而不是H2嵌入式数据库,请在

services部分下添加以下配置:mysql: image: mariadb:10.2 environment: MYSQL_DATABASE: dataflow MYSQL_USER: root MYSQL_ROOT_PASSWORD: rootpw expose: - 3306需要将以下条目添加到

dataflow-server服务定义的environment块中:- spring.datasource.url=jdbc:mysql://mysql:3306/dataflow - spring.datasource.username=root - spring.datasource.password=rootpw - spring.datasource.driver-class-name=org.mariadb.jdbc.Driver -

要使用RabbitMQ代替Kafka进行通信,请替换

services部分下的以下配置:kafka: image: wurstmeister/kafka:1.1.0 expose: - "9092" environment: - KAFKA_ADVERTISED_PORT=9092 - KAFKA_ZOOKEEPER_CONNECT=zookeeper:2181 - KAFKA_ADVERTISED_HOST_NAME=kafka zookeeper: image: wurstmeister/zookeeper expose: - "2181"附:

rabbitmq: image: rabbitmq:3.7 expose: - "5672"在

dataflow-server服务配置块中,添加以下environment条目:- spring.cloud.dataflow.applicationProperties.stream.spring.rabbitmq.host=rabbitmq最后,修改

app-import服务定义command属性,将bit.ly/Celsius-SR3-stream-applications-kafka-10-maven替换为bit.ly/Celsius-SR3-stream-applications-rabbit-maven。 -

要使用redis作为后端启用分析,请在

services部分下添加以下配置:redis: image: redis:2.8 expose: - "6379"然后将以下条目添加到

dataflow-server服务定义的environment块中:- spring.cloud.dataflow.applicationProperties.stream.spring.redis.host=redis - spring.redis.host=redis -

要直接从主机启用

app starters注册,您必须将源主机文件夹装载到dataflow-server容器。例如,如果my-app.jar位于主机上的/foo/bar/apps文件夹中,则将以下volumes块添加到dataflow-server服务定义中:dataflow-server: image: springcloud/spring-cloud-dataflow-server-local:${DATAFLOW_VERSION} container_name: dataflow-server ports: - "9393:9393" environment: - spring.cloud.dataflow.applicationProperties.stream.spring.cloud.stream.kafka.binder.brokers=kafka:9092 - spring.cloud.dataflow.applicationProperties.stream.spring.cloud.stream.kafka.binder.zkNodes=zookeeper:2181 volumes: - /foo/bar/apps:/root/apps稍后,可以从容器的

/root/apps/文件夹中访问my-app.jar(以及文件夹中的其他文件)。检查撰写文件参考以了解其他配置详细信息。显式卷安装将docker-compose耦合到主机的文件系统,从而限制了对其他计算机和操作系统的可移植性。与 docker不同,docker-compose不允许从命令行进行卷安装(例如,没有-v类参数)。相反,您可以定义占位符环境变量(例如HOST_APP_FOLDER)来代替硬编码路径:- ${HOST_APP_FOLDER}:/root/apps并在启动docker-compose之前设置此变量。dataflow:>app register --type source --name my-app --uri file://root/apps/my-app.jar如果元数据jar在/ root / apps中可用,也可以使用 --metadata-uri。要从

dataflow-server容器中访问主机的本地maven存储库,您应该将主机maven本地存储库(OSX和Linux的默认值为~/.m2,Windows的默认值为C:\Documents and Settings{your-username}\.m2)挂载到名为{的dataflow-server卷。 5 /}。对于MacOS或Linux主机,这看起来像这样:dataflow-server: ......... volumes: - ~/.m2:/root/.m2现在,您可以使用

maven://URI模式和maven坐标来解析安装在主机maven存储库中的jar:dataflow:>app register --type processor --name pose-estimation --uri maven://org.springframework.cloud.stream.app:pose-estimation-processor-rabbit:2.0.2.BUILD-SNAPSHOT --metadata-uri maven://org.springframework.cloud.stream.app:pose-estimation-processor-rabbit:jar:metadata:2.0.2.BUILD-SNAPSHOT --force这种方法允许您直接与数据流服务器容器共享构建并安装在主机上的jar(例如

mvn clean install)。也可以直接在docker-compose中预先注册应用程序。对于每个预先注册的app starer,在

app-import块配置中添加一个额外的wget语句:app-import: image: alpine:3.7 command: > /bin/sh -c " .... wget -qO- 'http://dataflow-server:9393/apps/source/my-app' --post-data='uri=file:/root/apps/my-app.jar&metadata-uri=file:/root/apps/my-app-metadata.jar'; echo 'My custom apps imported'"有关更多详细信息,请查看SCDF REST API。

-

要启用Spring Cloud Skipper以及Metrics支持,需要进行以下修改。在此示例中,假设stock

docker-compose.yml文件用作起点。仍然可以应用自定义,例如使用上面的示例与Rabbit交换Kafka。首先,在

zookeeper服务定义之后:-

按照使用Redis启用分析中所述添加Redis

然后在

dataflow-server服务定义下添加Skipper和Metrics:skipper-server: image: springcloud/spring-cloud-skipper-server:1.1.2.RELEASE container_name: skipper ports: - "7577:7577" - "9000-9010:9000-9010" environment: - spring.datasource.url=jdbc:mysql://mysql:3306/dataflow - spring.datasource.username=root - spring.datasource.password=rootpw - spring.datasource.driver-class-name=org.mariadb.jdbc.Driver metrics-collector: image: springcloud/metrics-collector-kafka:2.0.0.RELEASE environment: - spring.cloud.stream.kafka.binder.brokers=kafka:9092 - spring.cloud.stream.kafka.binder.zkNodes=zookeeper:2181 - spring.autoconfigure.exclude=org.springframework.boot.autoconfigure.security.servlet.SecurityAutoConfiguration expose: - "8080"从

dataflow-server删除应用程序端口映射,因为它们现在已分配给skipper-server容器:dataflow-server: ... ports: - "9393:9393" - "9000-9010:9000-9010"变为:

dataflow-server: ... ports: - "9393:9393"最后将以下环境变量附加到

dataflow-serverenvironment块:- spring.cloud.dataflow.features.skipper-enabled=true - spring.cloud.skipper.client.serverUri=http://skipper-server:7577/api使用Skipper时,已启动的应用程序及其日志驻留在 skipper容器而不是dataflow-server容器中。例如,如前所述查看流日志时,将引用skipper容器:$ docker exec -it skipper tail -f /path/from/stdout/textbox/in/dashboard

5.手动安装入门

-

下载Spring Cloud Data Flow服务器和Shell应用程序:

wget https://repo.spring.io/release/org/springframework/cloud/spring-cloud-dataflow-server-local/1.7.3.RELEASE/spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar wget https://repo.spring.io/release/org/springframework/cloud/spring-cloud-dataflow-shell/1.7.3.RELEASE/spring-cloud-dataflow-shell-1.7.3.RELEASE.jar从1.3.x开始,数据流服务器可以以

skipper或classic模式运行。classic模式是数据流服务器在1.2.x版本中的工作方式。使用属性spring.cloud.dataflow.features.skipper-enabled启动数据流服务器时指定模式。默认情况下,启用classic模式。 -

如果您希望在Streams中升级和回滚应用程序的附加功能,请下载Skipper,因为Data Flow会委托Skipper获取这些功能。

wget https://repo.spring.io/release/org/springframework/cloud/spring-cloud-skipper-server/1.1.2.RELEASE/spring-cloud-skipper-server-1.1.2.RELEASE.jar wget https://repo.spring.io/release/org/springframework/cloud/spring-cloud-skipper-shell/1.1.2.RELEASE/spring-cloud-skipper-shell-1.1.2.RELEASE.jar -

启动Skipper(仅当您要在

skipper模式下运行Spring Cloud Data Flow服务器时才需要)在您下载Skipper的目录中,使用

java -jar运行服务器,如下所示:$ java -jar spring-cloud-skipper-server-1.1.2.RELEASE.jar -

启动数据流服务器

在下载数据流的目录中,使用

java -jar运行服务器,如下所示:要以

classic模式运行数据流服务器:$ java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar要以

skipper模式运行数据流服务器:$ java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar --spring.cloud.dataflow.features.skipper-enabled=true如果Skipper和数据流服务器未在同一主机上运行,请将配置属性

spring.cloud.skipper.client.serverUri设置为Skipper的位置,例如$ java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar --spring.cloud.skipper.client.serverUri=http://192.51.100.1:7577/api -

启动数据流Shell,如下所示:

启动Data Flow shell需要指定适当的数据流服务器模式。要以

classic模式运行的数据流服务器启动数据流Shell:$ java -jar spring-cloud-dataflow-shell-1.7.3.RELEASE.jar要以

skipper模式运行的数据流服务器启动数据流Shell:$ java -jar spring-cloud-dataflow-shell-1.7.3.RELEASE.jar --dataflow.mode=skipper数据流服务器和命令行管理程序必须处于同一模式。 如果数据流服务器和shell未在同一主机上运行,则在shell的交互模式下,您还可以使用

dataflow config server命令将shell指向数据流服务器URL。如果数据流服务器和shell未在同一主机上运行,请将shell指向数据流服务器URL,如下所示:

server-unknown:>dataflow config server http://198.51.100.0 Successfully targeted http://198.51.100.0 dataflow:>或者,传入命令行选项

--dataflow.uri。shell的命令行选项--help显示可用的内容。

6.部署Streams

-

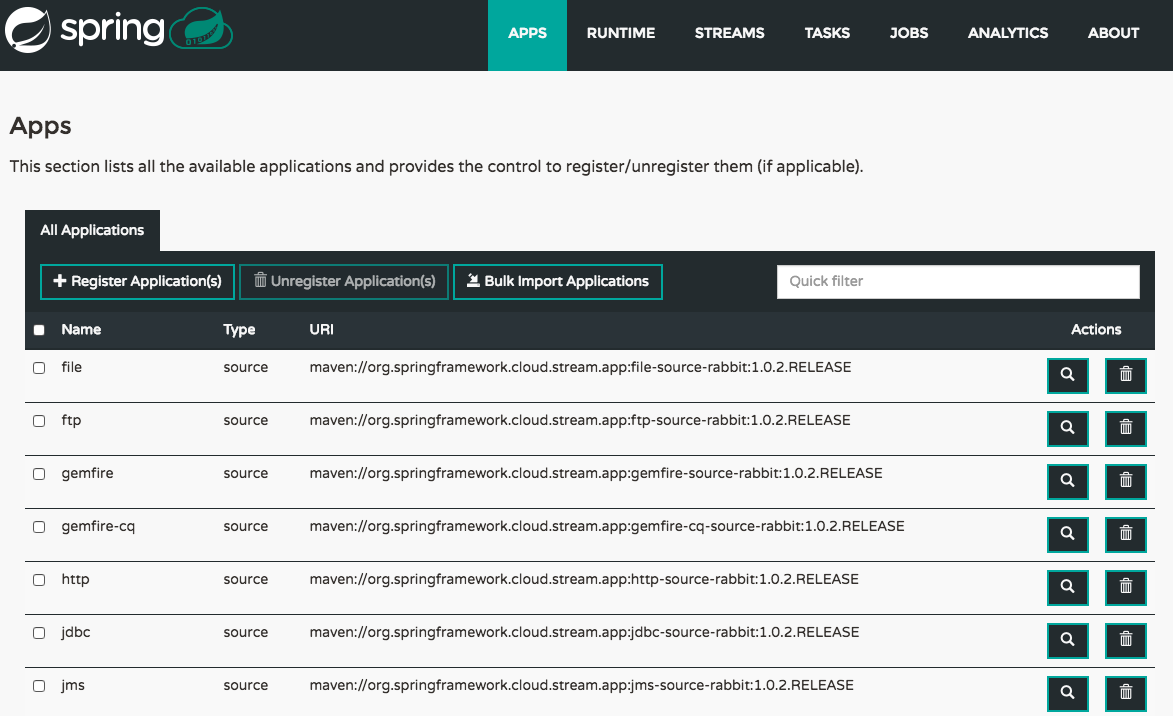

注册流应用

默认情况下,应用程序注册表为空。例如,注册使用RabbitMQ进行通信的两个应用程序

http和log。dataflow:>app register --name http --type source --uri maven://org.springframework.cloud.stream.app:http-source-rabbit:1.2.0.RELEASE Successfully registered application 'source:http' dataflow:>app register --name log --type sink --uri maven://org.springframework.cloud.stream.app:log-sink-rabbit:1.1.0.RELEASE Successfully registered application 'sink:log'有关更多详细信息,例如如何注册基于docker容器的应用程序或使用Kafka作为消息传递中间件,请查看有关如何注册应用程序的部分。

根据您的环境,您可能需要将数据流服务器配置为指向自定义Maven存储库位置或配置代理设置。有关更多信息,请参阅Maven。 在本入门部分中,我们仅显示部署流,因此命令在服务器的

skipper和classic模式下是相同的。 -

创建一个流

使用

stream create命令创建一个带有http源和log接收器的流并部署它:dataflow:> stream create --name httptest --definition "http --server.port=9000 | log" --deploy在发布数据之前,您需要等待一段时间,直到应用程序实际部署成功。查看数据流服务器的日志文件,以获取 http和log应用程序的日志文件的位置。对每个应用程序使用日志文件上的tail命令验证应用程序是否已启动。现在发布一些数据,如下例所示:

dataflow:> http post --target http://localhost:9000 --data "hello world"检查

hello world应用程序的日志文件中是否hello world结束。log应用程序的日志文件的位置将显示在数据流服务器的日志中。

您可以在使用Skipper的Stream Lifecycle部分以及如何使用Skipper在Streams中升级和回滚流中,阅读有关使用Skipper部署流的一般功能的更多信息。

|

在本地部署时,每个应用程序(以及每个应用程序实例,在 |

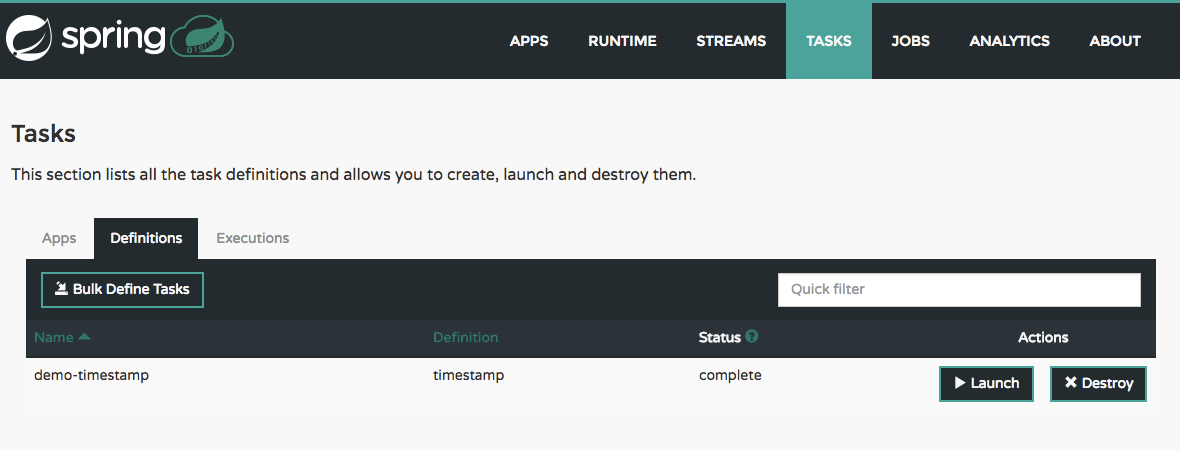

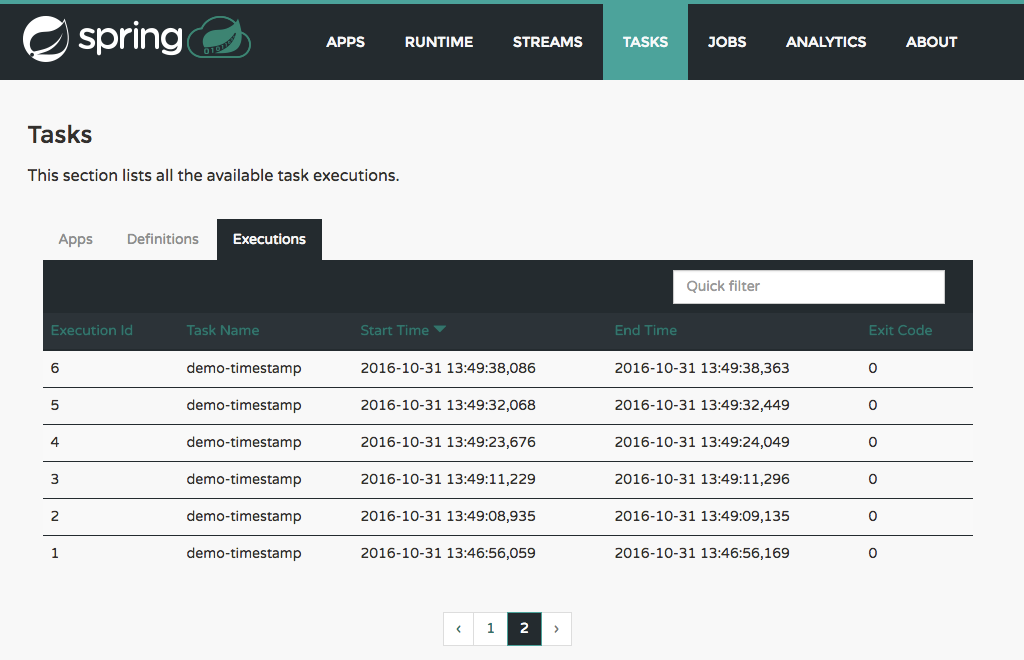

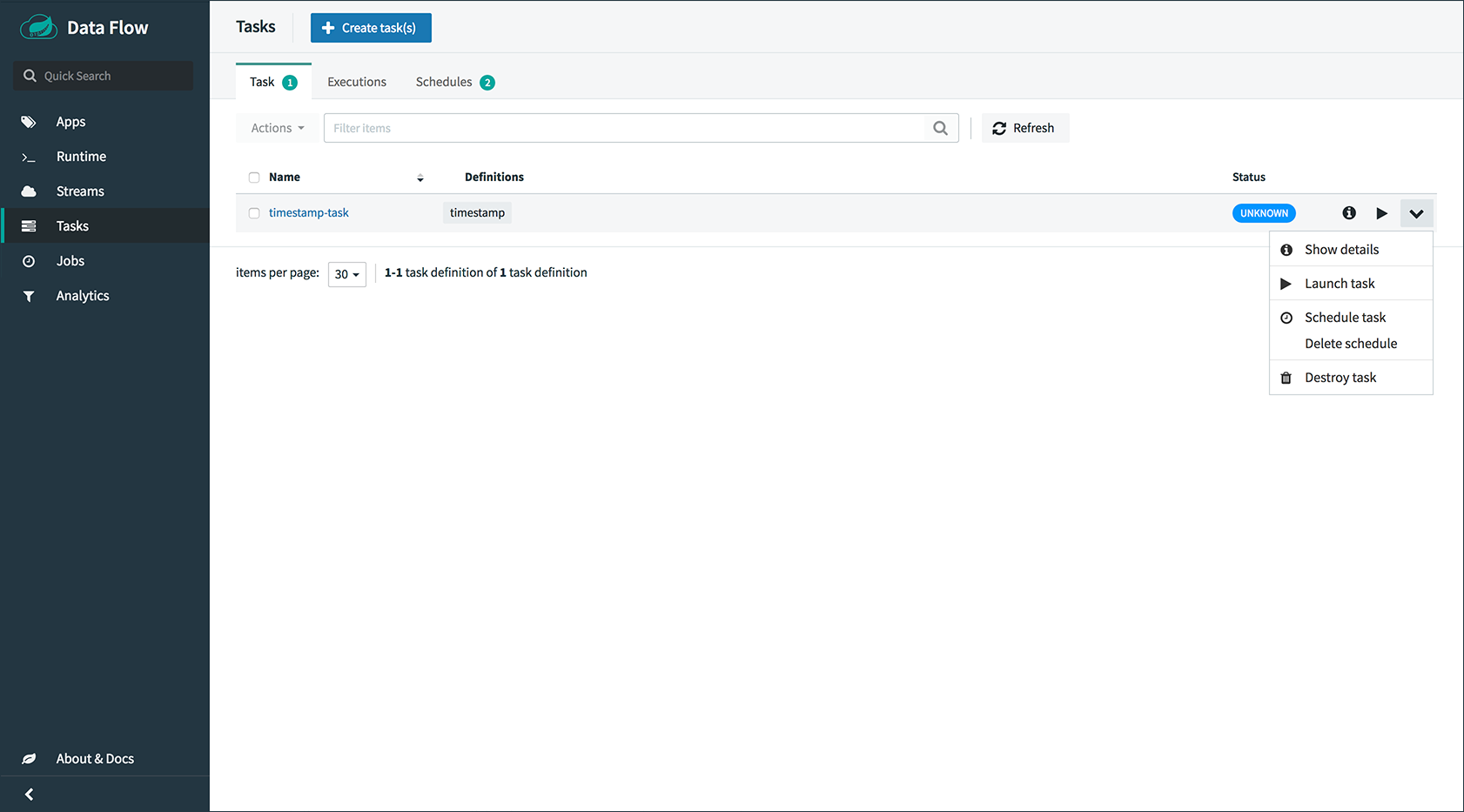

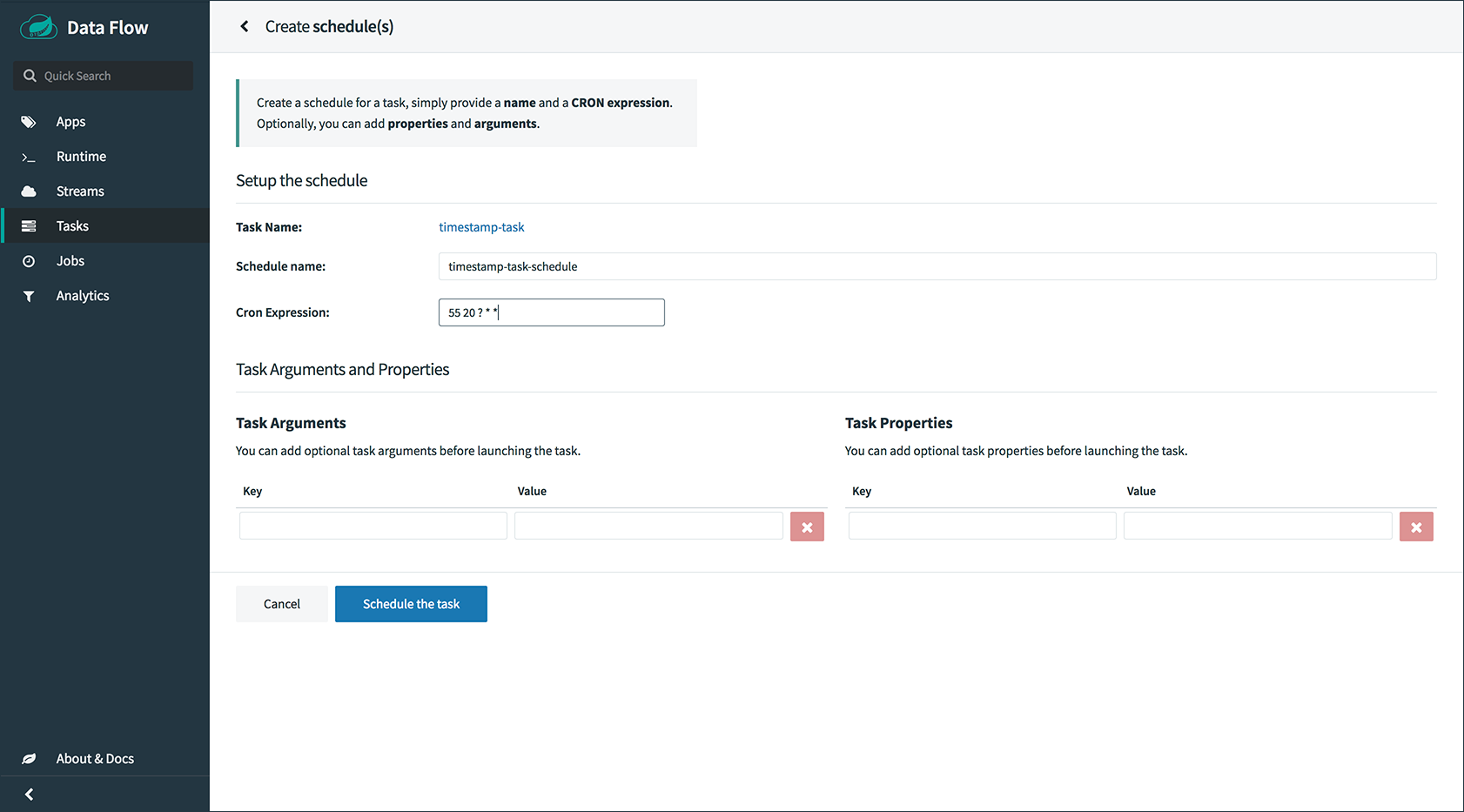

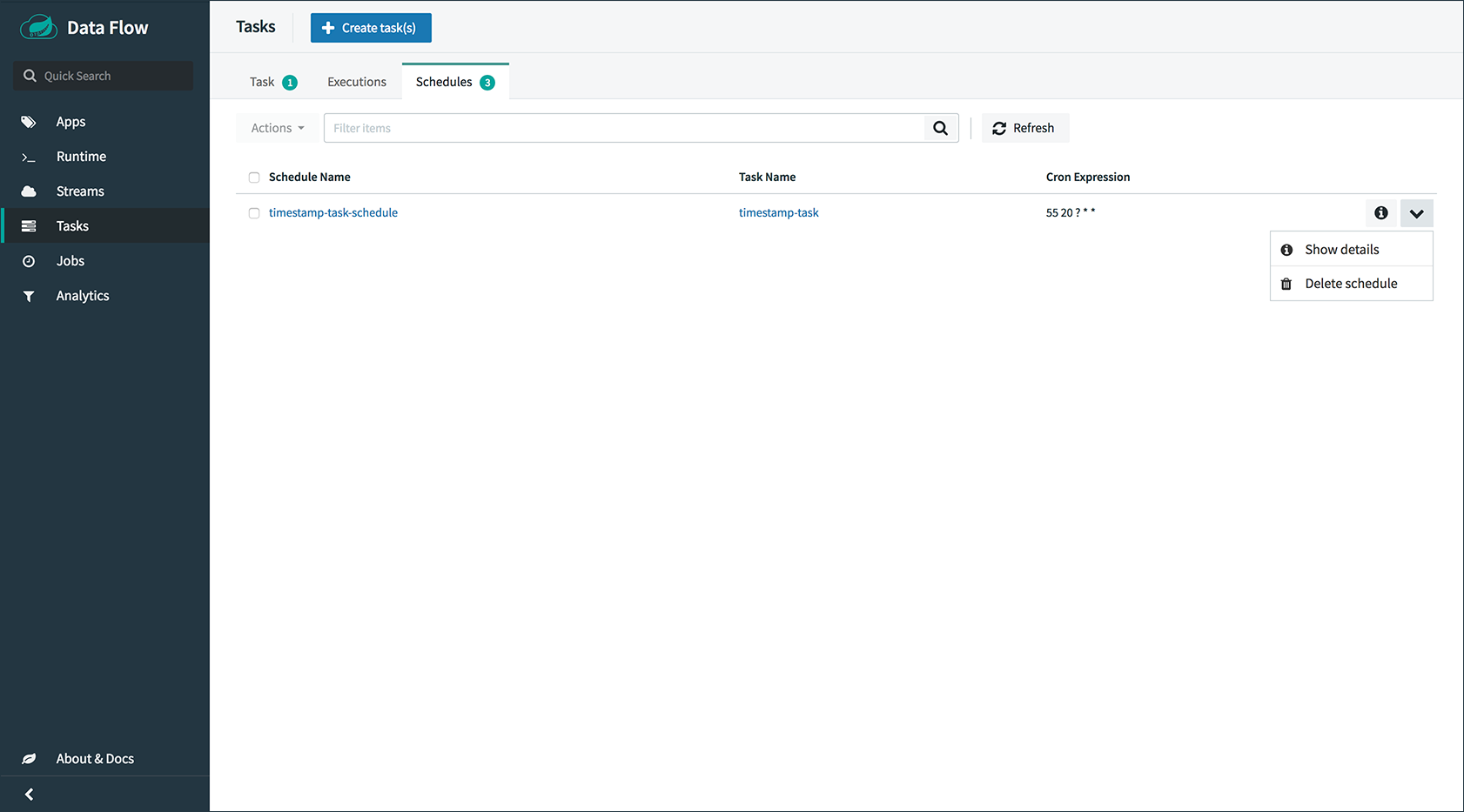

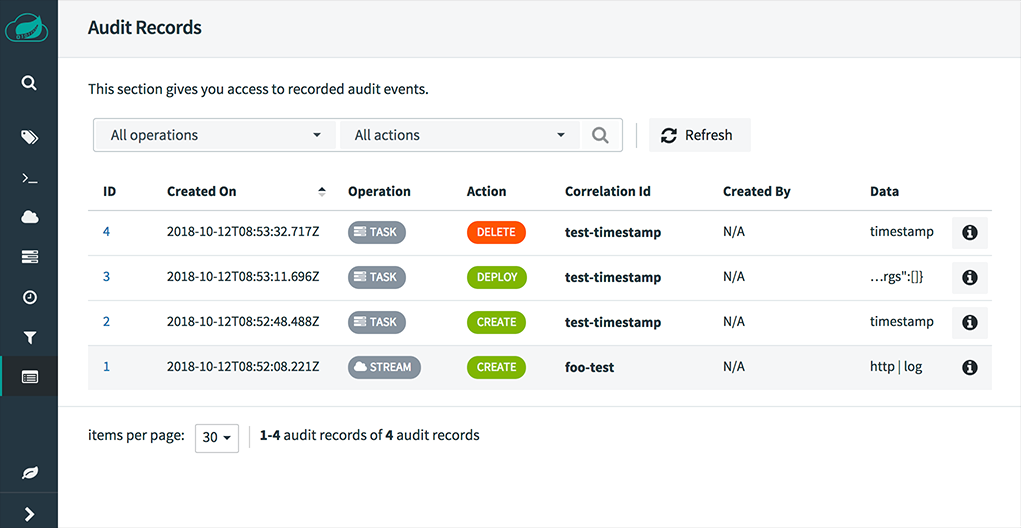

7.部署任务

在本入门部分,我们将展示如何注册任务,创建任务定义然后启动它。然后,我们还将审查有关任务执行的信息。

| 启动Spring Cloud Task应用程序不会委托给Skipper,因为它们是短期应用程序。通过数据流服务器直接部署任务。 |

-

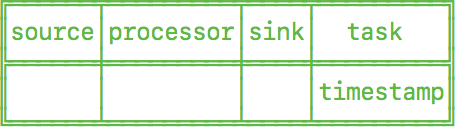

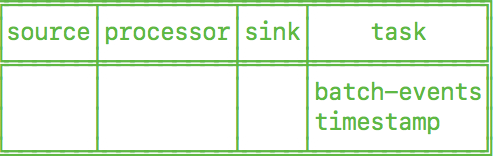

注册任务应用程序

默认情况下,应用程序注册表为空。例如,我们将注册一个任务应用程序

timestamp,它只是将当前时间打印到日志中。dataflow:>app register --name timestamp --type task --uri maven://org.springframework.cloud.task.app:timestamp-task:1.3.0.RELEASE Successfully registered application 'task:timestamp'根据您的环境,您可能需要将数据流服务器配置为指向自定义Maven存储库位置或配置代理设置。有关更多信息,请参阅Maven。 -

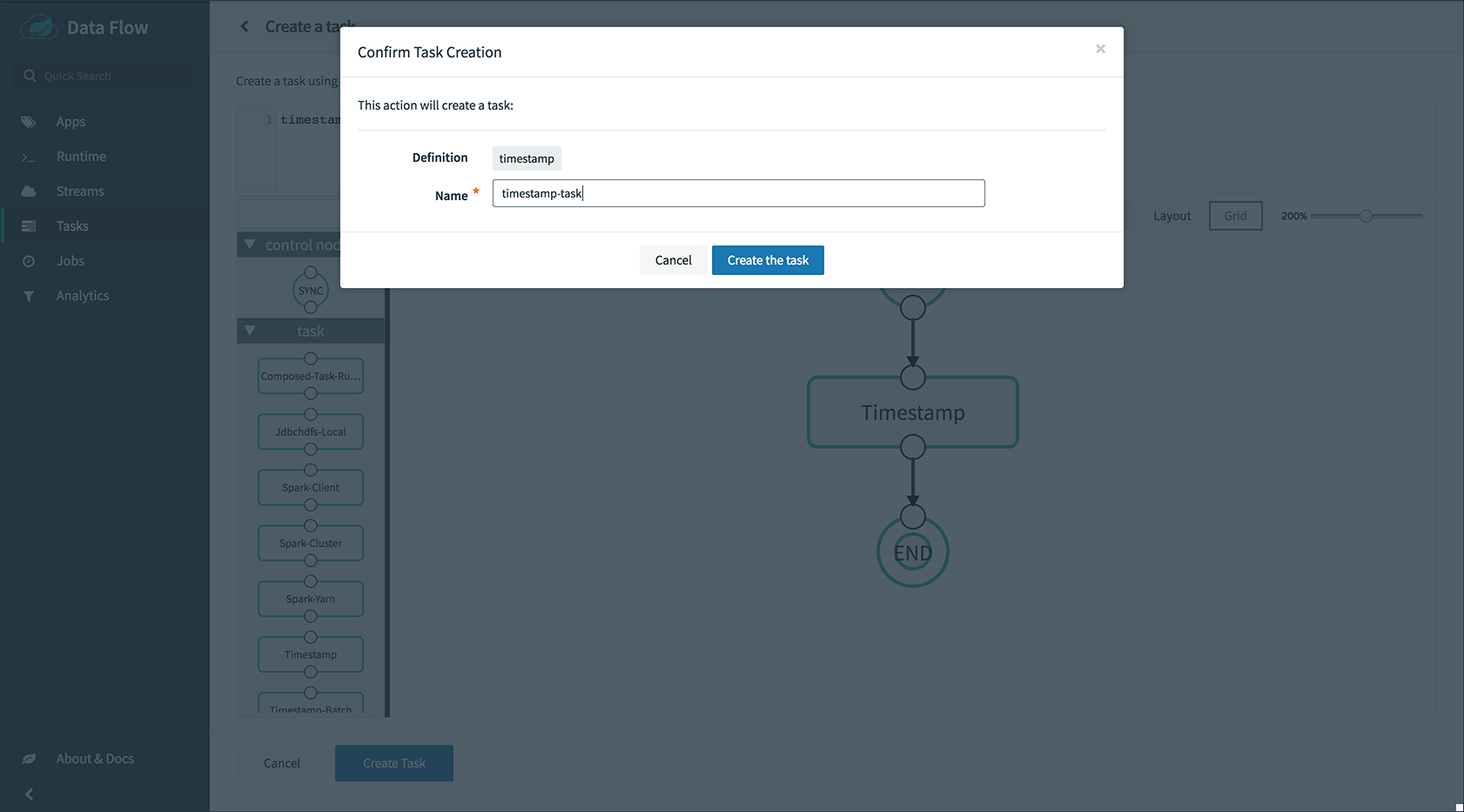

创建任务定义

使用

task create命令使用以前注册的timestamp应用程序创建任务定义。在此示例中,没有使用其他属性来配置timestamp应用程序。dataflow:> task create --name printTimeStamp --definition "timestamp" -

启动任务

任务定义的启动是通过shell的

task launch命令完成的。dataflow:> task launch printTimeStamp检查时间戳是否在时间戳任务的日志文件中结束。任务应用程序的日志文件的位置将显示在数据流服务器的日志中。您应该看到类似的日志条目

TimestampTaskConfiguration$TimestampTask : 2018-02-28 16:42:21.051 -

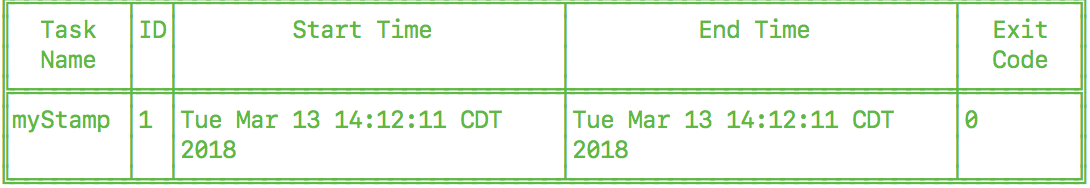

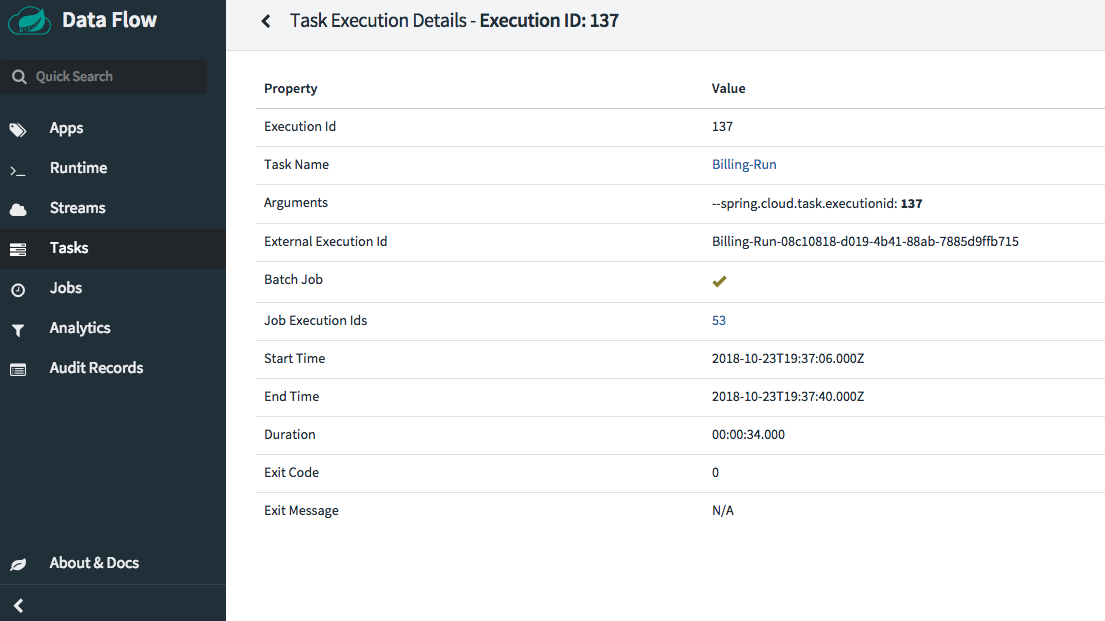

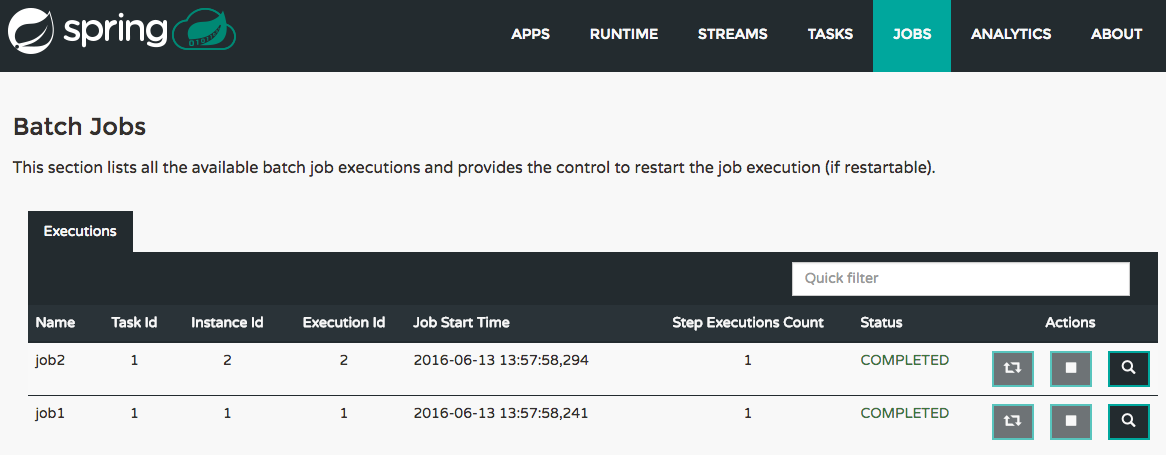

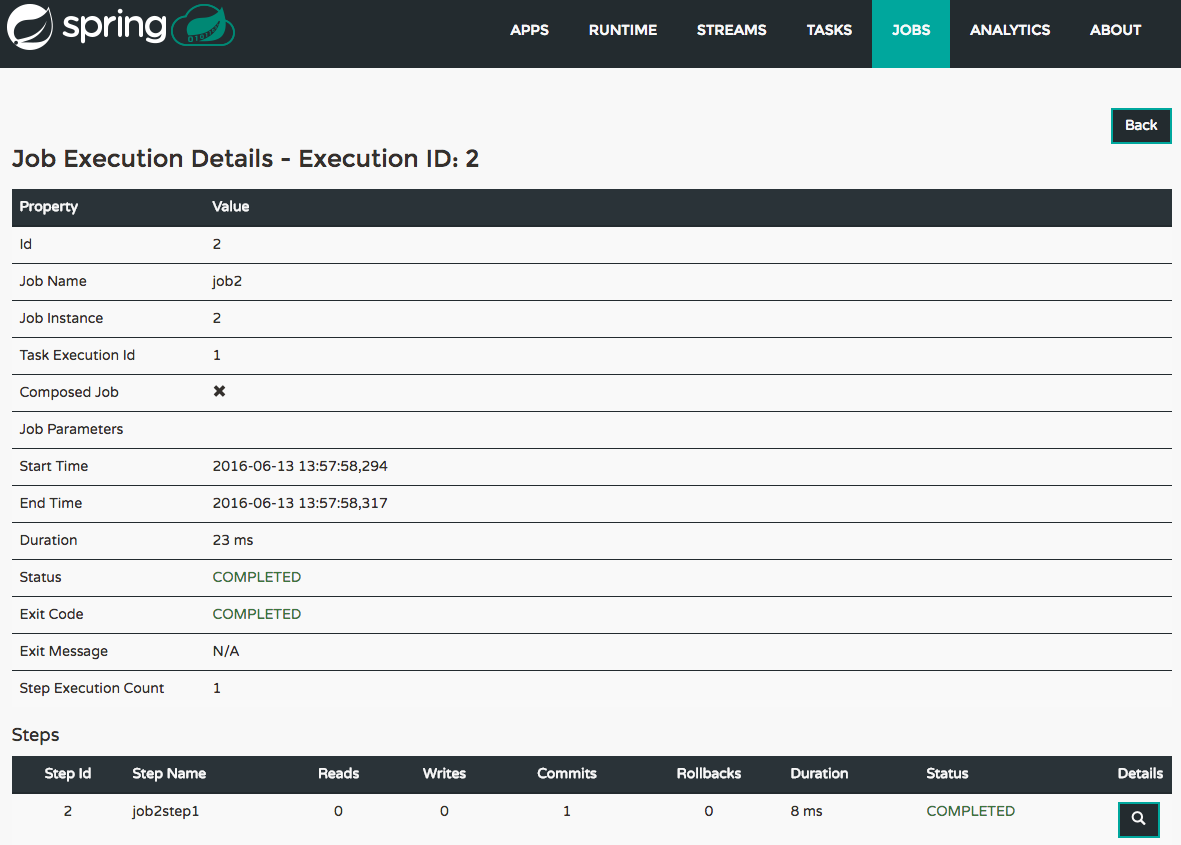

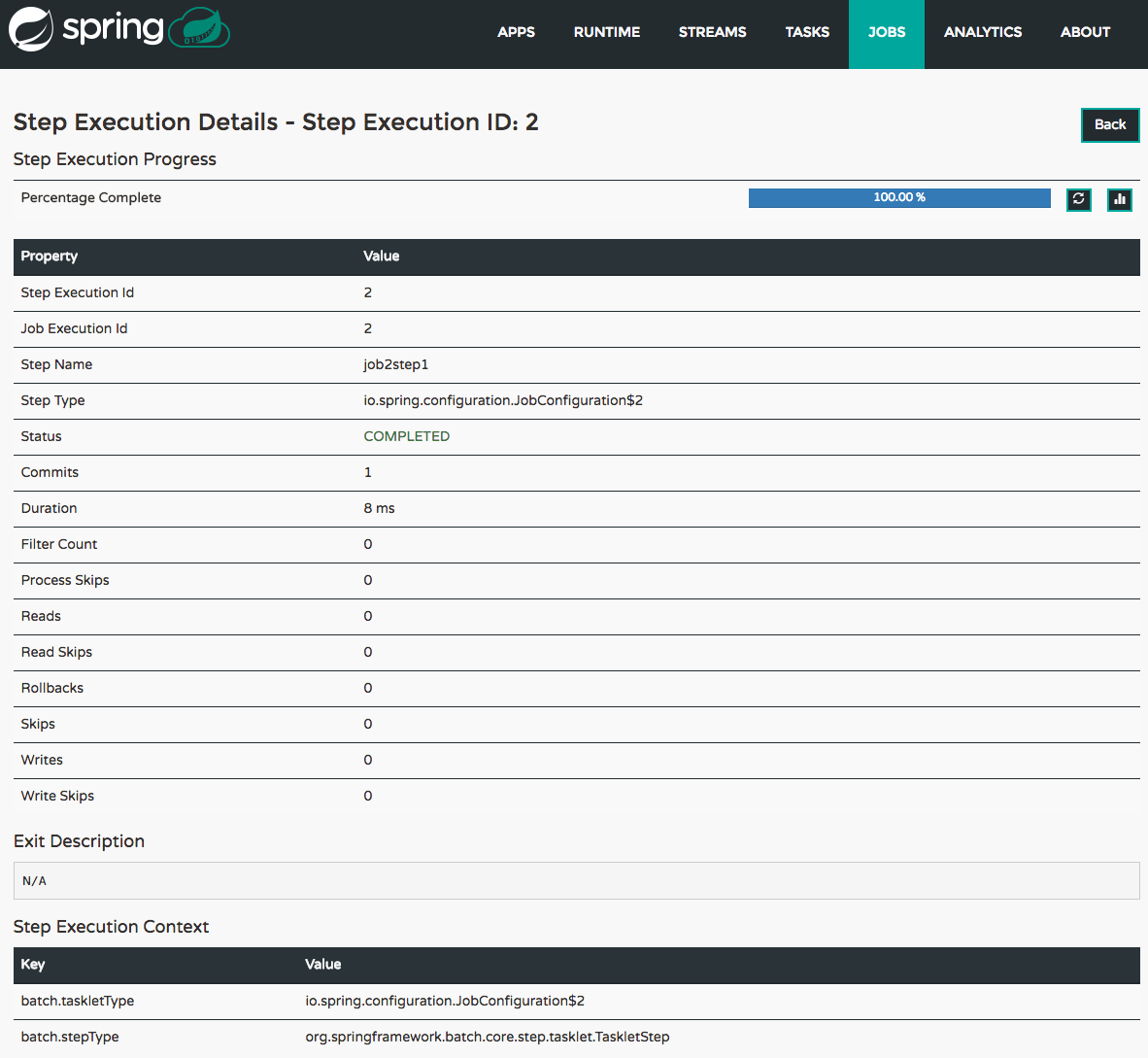

检查任务执行

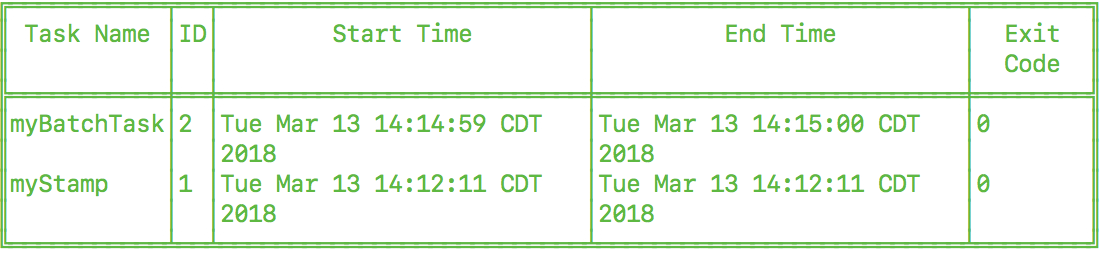

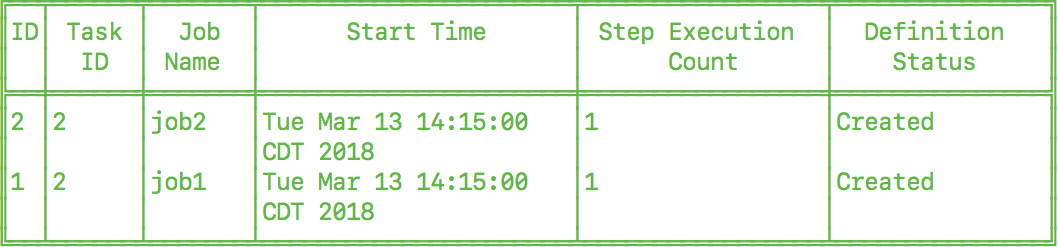

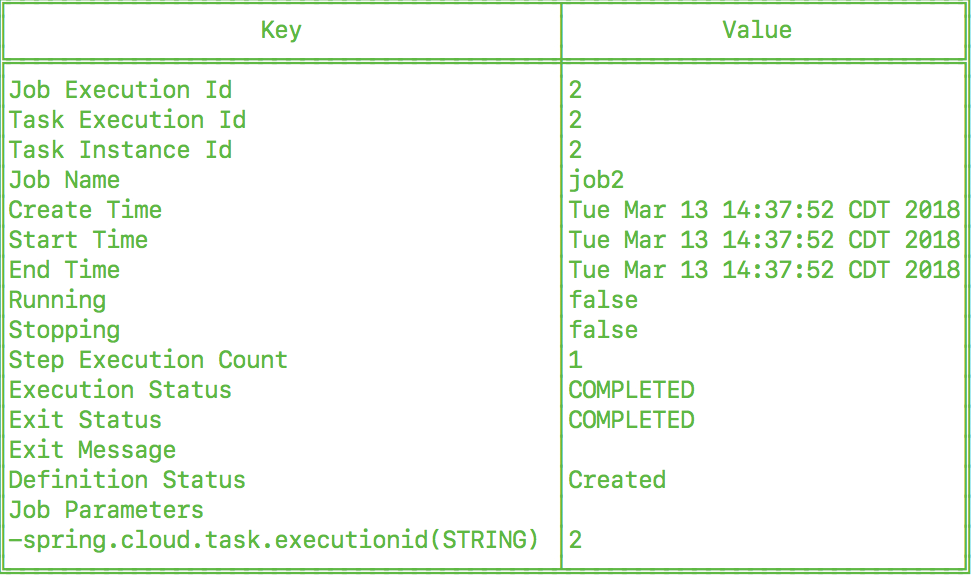

可以使用命令

task execution list获取有关任务执行的信息。dataflow:>task execution list ╔══════════════╤══╤════════════════════════════╤════════════════════════════╤═════════╗ ║ Task Name │ID│ Start Time │ End Time │Exit Code║ ╠══════════════╪══╪════════════════════════════╪════════════════════════════╪═════════╣ ║printTimeStamp│1 │Wed Feb 28 16:42:21 EST 2018│Wed Feb 28 16:42:21 EST 2018│0 ║ ╚══════════════╧══╧════════════════════════════╧════════════════════════════╧═════════╝可以使用命令

task execution status获取其他信息。dataflow:>task execution status --id 1 ╔══════════════════════╤═══════════════════════════════════════════════════╗ ║ Key │ Value ║ ╠══════════════════════╪═══════════════════════════════════════════════════╣ ║Id │1 ║ ║Name │printTimeStamp ║ ║Arguments │[--spring.cloud.task.executionid=1] ║ ║Job Execution Ids │[] ║ ║Start Time │Wed Feb 28 16:42:21 EST 2018 ║ ║End Time │Wed Feb 28 16:42:21 EST 2018 ║ ║Exit Code │0 ║ ║Exit Message │ ║ ║Error Message │ ║ ║External Execution Id │printTimeStamp-ab86b2cc-0508-4c1e-b33d-b3896d17fed7║ ╚══════════════════════╧═══════════════════════════════════════════════════╝

应用

8.可用应用程序

| 资源 | 处理器 | 下沉 | 任务 |

|---|---|---|---|

task-launcher-yarn |

|||

task-launcher-local |

|||

loggregator |

|||

tasklaunchrequest-transform |

|||

task-launcher-cloudfoundry |

架构

9.简介

Spring Cloud Data Flow简化了专注于数据处理用例的应用程序的开发和部署。该体系结构的主要概念是Applications,Data Flow Server和目标运行时。

应用程序有两种形式:

-

长期存在的Stream应用程序,通过消息传递中间件消耗或生成无限量的数据。

-

短期任务应用程序,处理有限的数据集然后终止。

根据运行时的不同,应用程序可以通过两种方式打包:

-

托管在maven存储库,文件或HTTP(S)中的Spring Boot uber-jar。

-

Docker图像。

运行时是应用程序执行的位置。应用程序的目标运行时是您可能已用于其他应用程序部署的平台。

支持的平台是:

-

Cloud Foundry

-

Kubernetes

-

本地服务器

| 生产中支持本地服务器以进行任务部署,以替代Spring Batch Admin项目。Stream部署的生产中不支持本地服务器。 |

有一个部署服务提供程序接口(SPI),允许您扩展数据流以部署到其他运行时。社区实施

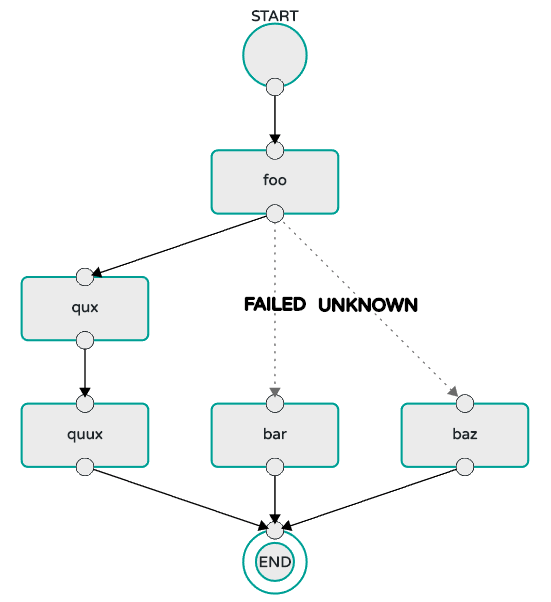

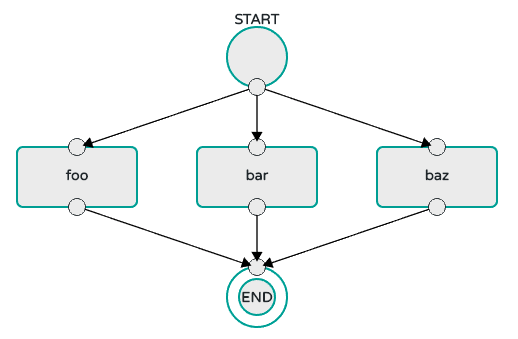

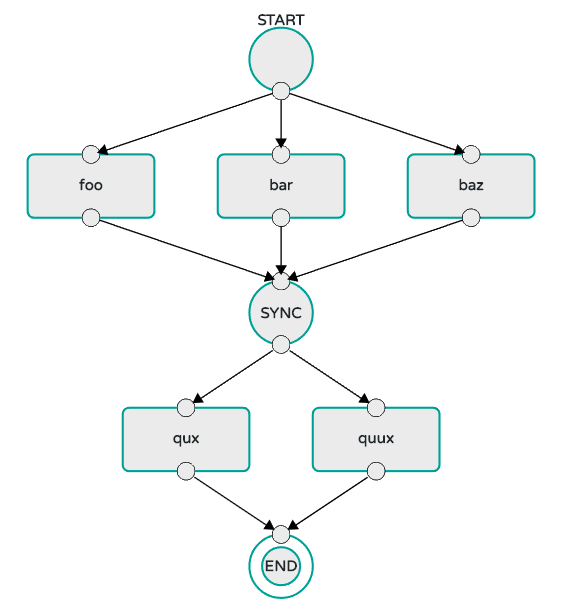

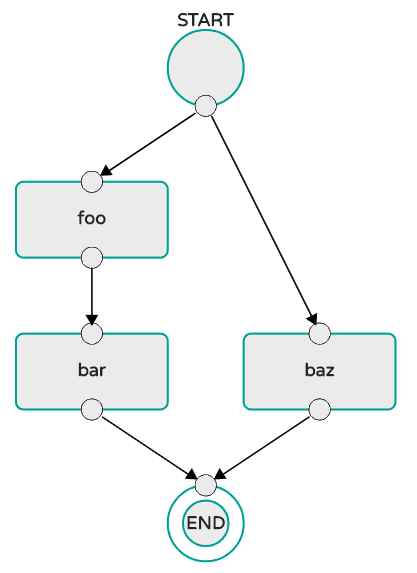

有两个互斥选项可确定将流应用程序部署到平台的时间。

-

选择面向单个平台的Spring Cloud Data Flow服务器可执行jar。

-

使Spring Cloud Data Flow服务器能够将应用程序的部署和运行时状态委派给Spring Cloud Skipper Server,后者具有部署到多个平台的能力。

选择Spring Cloud Skipper选项还可以在运行时更新和回滚Stream中的应用程序。

数据流服务器还负责:

-

解释和执行流DSL,该流描述通过多个长期存在的应用程序的数据逻辑流。

-

启动一个长期存在的任务应用程序。

-

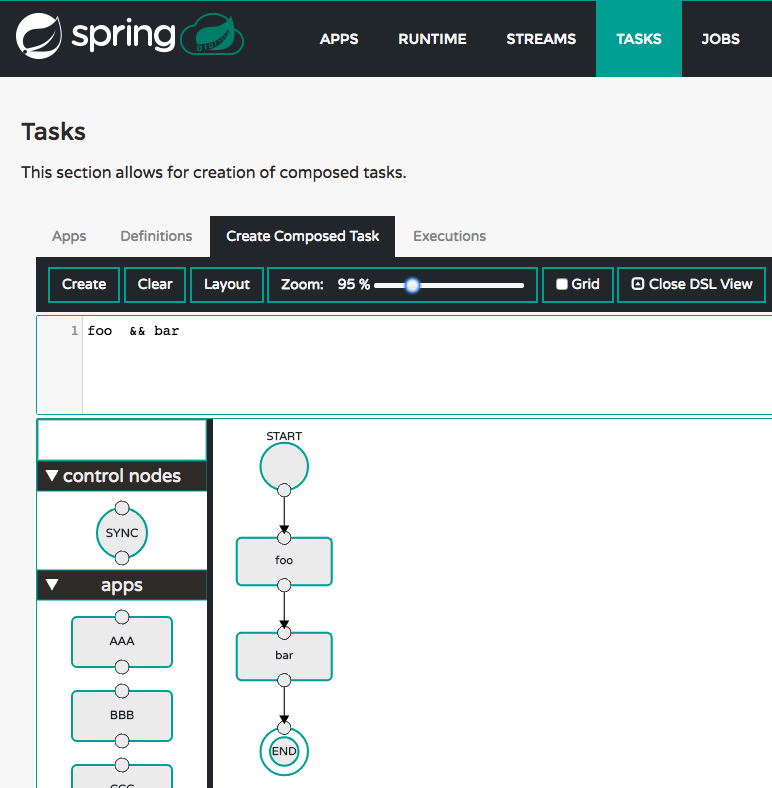

解释和执行组合任务DSL,描述通过多个短期应用程序的数据逻辑流程。

-

应用描述应用程序到运行时映射的部署清单 - 例如,设置初始实例数,内存要求和数据分区。

-

提供已部署应用程序的运行时状态。

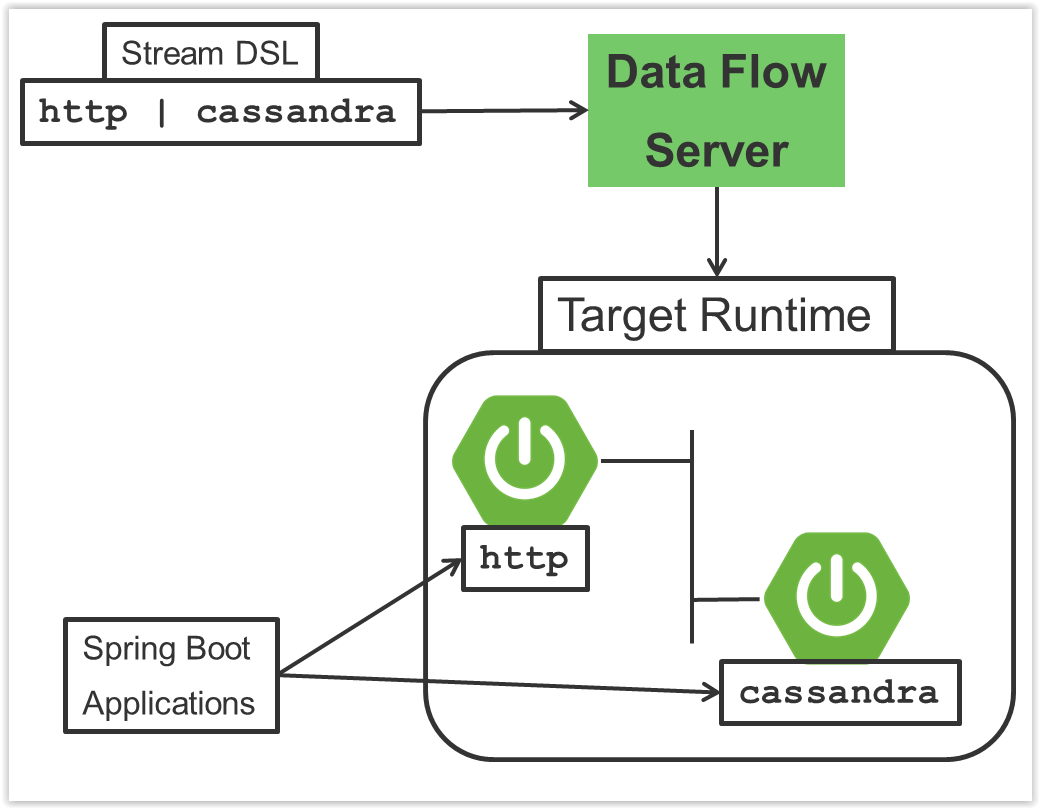

作为示例,用于描述从HTTP源到Apache Cassandra接收器的数据流的流DSL将使用Unix管道和过滤器语法“http | cassandra”来编写。DSL中的每个名称都映射到可以存储Maven或Docker存储库的应用程序。您还可以将申请注册到http位置。许多常见用例(例如JDBC,HDFS,HTTP和路由器)的源,处理器和接收器应用程序由Spring Cloud Data Flow团队提供。管道符号表示通过消息传递中间件在两个应用程序之间进行通信。支持的两个消息传递中间件代理是:

-

Apache Kafka

-

RabbitMQ

在Kafka的情况下,在部署流时,数据流服务器负责创建与每个管道符号对应的主题,并配置每个应用程序以生成或使用主题,从而实现所需的数据流。类似地,对于RabbitMQ,根据需要创建交换和队列以实现期望的流。

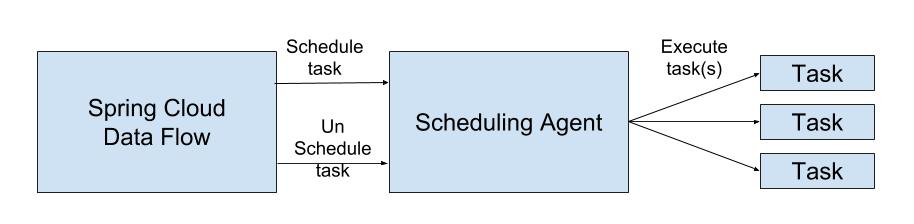

主要组件的交互如下图所示:

在上图中,流的DSL描述被POST到数据流服务器。基于DSL应用程序名称到Maven和Docker工件的映射,http-source和cassandra-sink应用程序部署在目标运行时上。然后,发布到HTTP应用程序的数据将存储在Cassandra中。的样品Repository显示了在全部细节这种使用情况。

10.微服务架构风格

数据流服务器将应用程序部署到符合微服务架构风格的目标运行时。例如,流表示一个高级应用程序,它由多个小型微服务应用程序组成,每个应用程序都在自己的进程中运行。每个微服务应用程序可以独立于另一个扩展或缩小,并且每个应用程序都有自己的版本控制生命周期。通过使用带有Skipper的数据流,您可以在运行时独立升级或回滚每个应用程序。

Streaming和基于任务的微服务应用程序都基于Spring Boot作为基础库。这为所有微服务应用程序提供了诸如运行状况检查,安全性,可配置日志记录,监视和管理功能以及可执行JAR打包等功能。

需要强调的是,这些微服务应用程序只是“应用程序”,您可以使用java -jar并传递适当的配置属性来自行运行。我们为常见操作提供了许多常见的微服务应用程序,因此在处理基于Spring项目的丰富生态系统的常见用例时,您无需从头开始,例如Spring Integration,Spring Data和Spring Batch。创建自己的微服务应用程序与创建其他Spring Boot应用程序类似。您可以首先使用Spring Initializr web站点来创建基于Stream或任务的微服务的基本支架。

除了将适当的应用程序属性传递给每个应用程序之外,数据流服务器还负责准备目标平台的基础结构,以便可以部署应用程序。例如,在Cloud Foundry中,它会将指定的服务绑定到应用程序,并为每个应用程序执行cf push命令。对于Kubernetes,它将创建复制控制器,服务和负载均衡器。

数据流服务器有助于简化将多个相关应用程序部署到目标运行时,设置必要的输入和输出主题,分区和度量标准功能。但是,也可以选择手动部署每个微服务应用程序,而根本不使用数据流。对于小规模部署而言,这种方法可能更合适,在开发更多应用程序时逐渐采用数据流的便利性和一致性。手动部署基于流和任务的微服务也是一项有用的教育练习,可以帮助您更好地理解数据流服务器提供的一些自动应用程序配置和平台定位步骤。

10.1.与其他平台架构的比较

Spring Cloud Data Flow的架构风格与其他Stream和Batch处理平台不同。例如,在Apache Spark,Apache Flink和Google Cloud Dataflow中,应用程序在专用计算引擎集群上运行。与Spring Cloud Data Flow相比,计算引擎的性质为这些平台提供了更丰富的环境,可以对数据执行复杂的计算,但它引入了创建以数据为中心的应用程序时通常不需要的另一个执行环境的复杂性。这并不意味着您在使用Spring Cloud Data Flow时无法进行实时数据计算。请参阅“ 分析 ”部分,该部分描述了Redis与处理常见的基于计数的用例的集成。Spring Cloud Stream还支持使用Reactive API,例如Project Reactor和RxJava,这对于创建包含时间滑动窗口和移动平均功能的功能样式应用程序非常有用。同样,Spring Cloud Stream也支持使用Kafka Streams API 开发应用程序。

Apache Storm,Hortonworks DataFlow和Spring Cloud Data Flow的前身Spring XD使用专用的应用程序执行集群,该集群对每个产品都是唯一的,它确定代码应在集群上运行的位置并执行运行状况检查以确保如果失败,则重新启动长期应用程序。通常,需要特定于框架的接口才能正确地“插入”到集群的执行框架。

正如我们在Spring XD的发展过程中发现的那样,2015年多个容器框架的兴起使我们自己的运行时创建了重复工作。当有多个运行时平台已经提供此功能时,没有理由构建自己的资源管理机制。考虑到这些因素是我们转向当前架构的原因,我们将执行委托给流行的运行时,您可能已将其用于其他目的。这是一个优势,因为它减少了创建和管理以数据为中心的应用程序的认知距离,因为许多用于部署其他最终用户/ web应用程序的相同技能都适用。

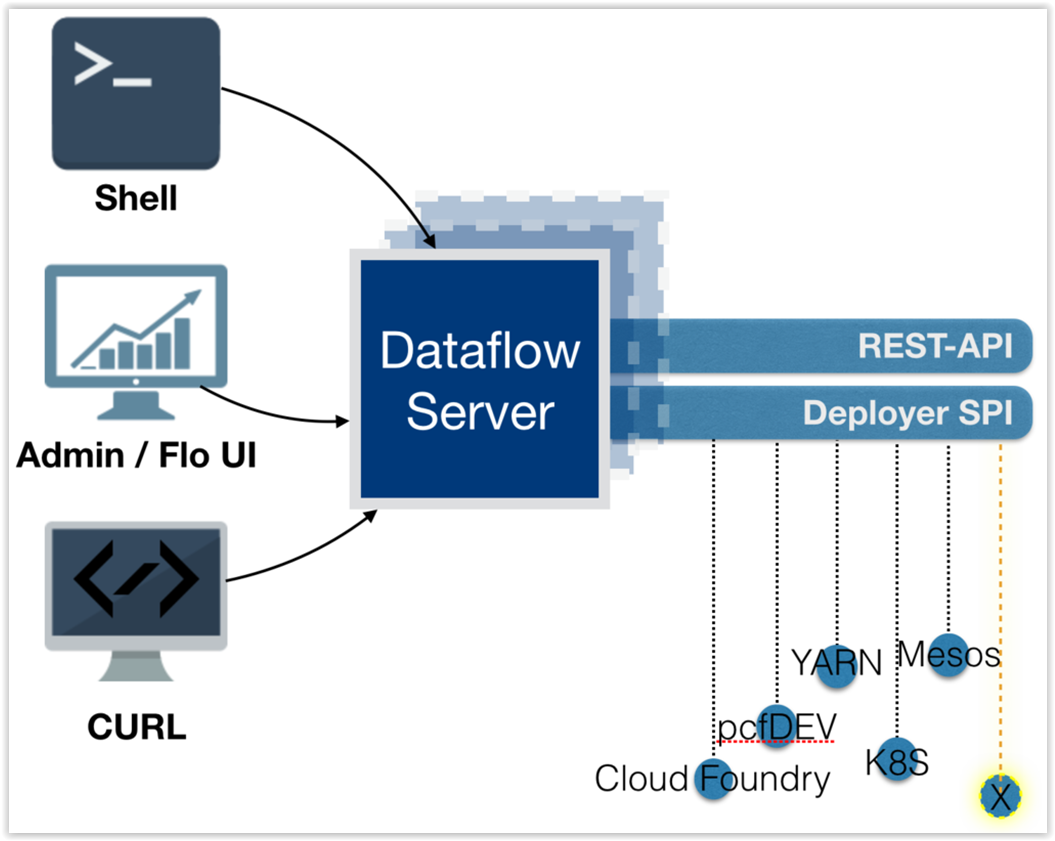

11.数据流服务器

数据流服务器提供以下功能:

11.1.端点

数据流服务器使用嵌入式servlet容器并公开REST端点,用于创建,部署,取消部署和销毁流和任务,查询运行时状态,分析等。数据流服务器通过使用Spring的MVC框架和Spring HATEOAS库来实现,以创建遵循HATEOAS原则的REST表示,如下图所示:

[注意]将应用程序部署到本地计算机的数据流服务器不打算用于流式用例的生产,而是用于开发和测试基于流的应用程序。本地数据流量是打算在生产中使用批量使用情况作为Spring Batch管理项目的替代品。流式和批量使用情况都是在部署到Cloud Foundry或Kuberenetes时用于生产。

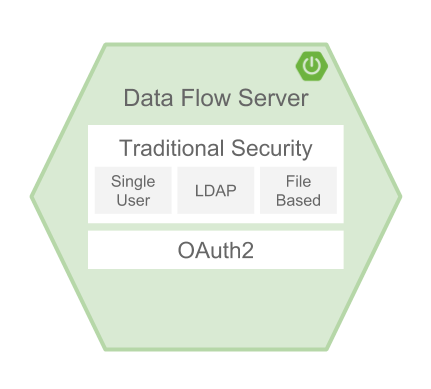

11.2.安全

数据流服务器可执行jar支持基本HTTP,LDAP(S),基于文件和OAuth 2.0身份验证以访问其端点。有关更多信息,请参阅安全性部分。

12.流

12.1.拓扑

Stream DSL描述了流经系统的线性数据序列。例如,在流定义http | transformer | cassandra中,每个管道符号将左侧的应用程序连接到右侧的应用程序。命名通道可用于路由和扇出/扇出数据到多个消息传递目的地。

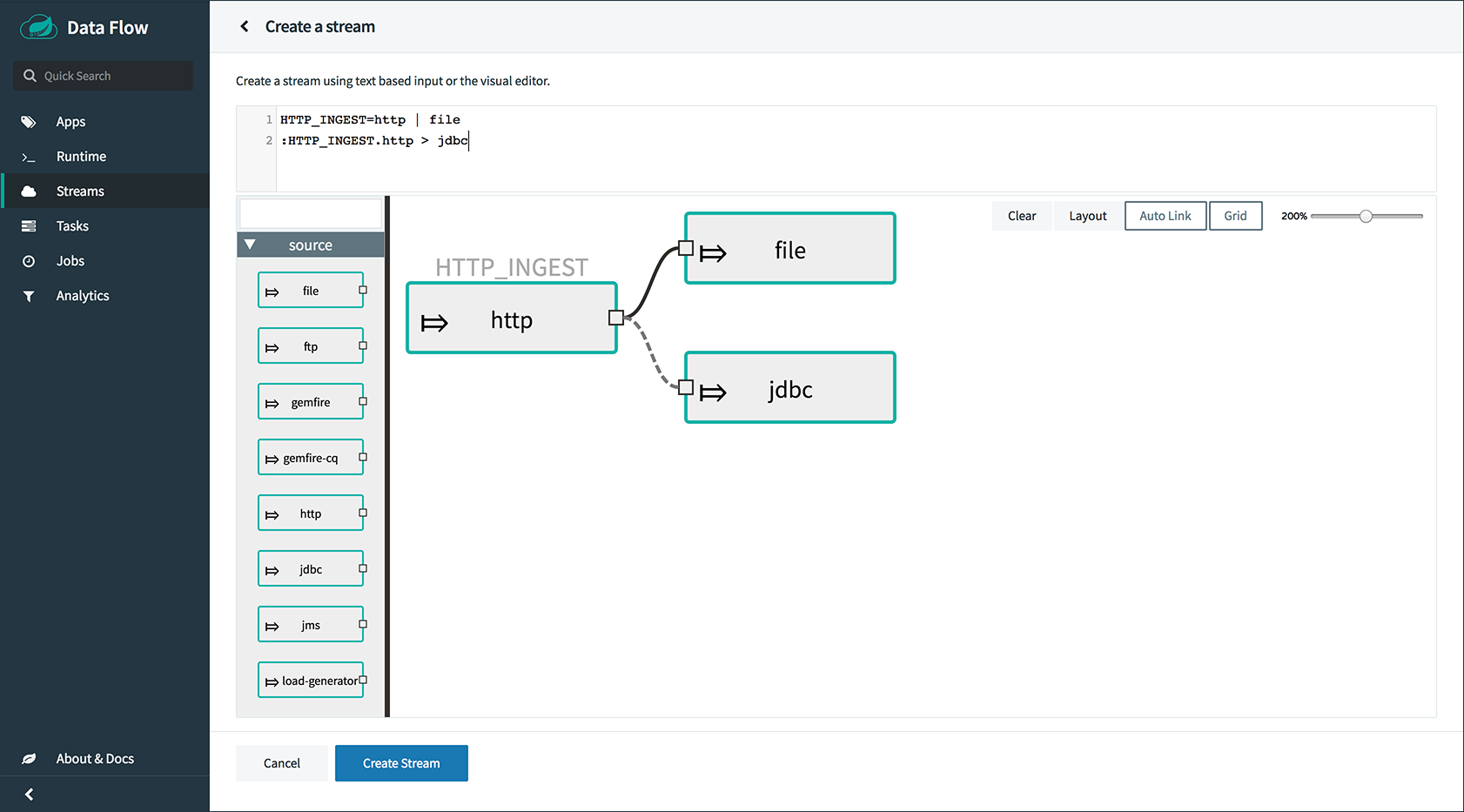

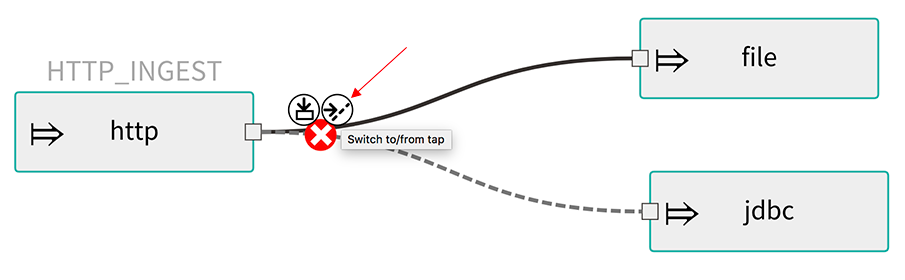

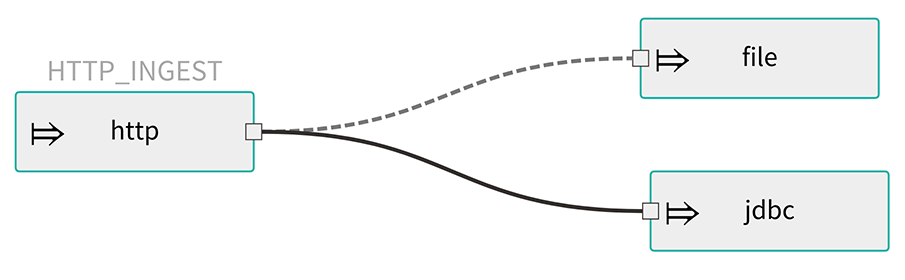

敲击的概念可用于“监听”流过任何管道符号的数据。“Taps”只是其他流,它们使用输入目标流中的任何一个“管道”,并且与目标流具有独立的生命周期。

12.2.并发

对于使用事件的应用程序,Spring Cloud Stream公开了一个并发设置,该设置控制用于调度传入消息的线程池的大小。有关更多信息,请参阅使用者属性文档。

12.3.分区

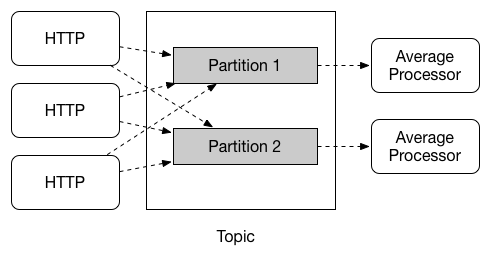

流处理中的常见模式是在数据从一个应用程序移动到下一个应用程序时对数据进行分区。出于性能或一致性原因,分区是有状态处理中的关键概念,以确保所有相关数据一起处理。例如,在时间窗口平均计算示例中,重要的是来自任何给定传感器的所有测量都由相同的应用实例处理。或者,您可能希望缓存与传入事件相关的一些数据,以便可以在不进行远程过程调用的情况下丰富它以检索相关数据。

Spring Cloud Data Flow通过配置Spring Cloud Stream的输出和输入绑定来支持分区。Spring Cloud Stream提供了一种通用抽象,用于跨不同类型的中间件以统一的方式实现分区处理用例。因此,无论代理本身是自然分区(例如,Kafka主题)还是不分区(RabbitMQ),都可以使用分区。下图显示了如何将数据分区为两个存储区,以便平均处理器应用程序的每个实例都使用一组唯一的数据。

要在Spring Cloud Data Flow中使用简单的分区策略,您只需为流中的每个应用程序设置实例计数,并在部署流时设置partitionKeyExpression生产者属性。partitionKeyExpression标识消息的哪个部分用作分区底层中间件中数据的密钥。ingest流可以定义为http | averageprocessor | cassandra。(请注意,Cassandra接收器未在上图中显示。)假设发送到HTTP源的有效负载是JSON格式,并且有一个名为sensorId的字段。例如,考虑使用shell命令stream deploy ingest --propertiesFile ingestStream.properties部署流的情况,其中ingestStream.properties文件的内容如下:

deployer.http.count=3

deployer.averageprocessor.count=2

app.http.producer.partitionKeyExpression=payload.sensorId结果是部署流,以便配置所有输入和输出目标以使数据流过应用程序,同时确保始终将一组唯一数据传递到每个averageprocessor实例。在这种情况下,默认算法是评估payload.sensorId % partitionCount partitionCount,其中partitionCount是RabbitMQ的应用程序计数,而Kafka是主题的分区计数。

有关在部署期间对流进行分区的其他策略以及它们如何映射到基础Spring Cloud Stream分区属性,请参阅传递流分区Properties。

12.4.消息传递保证

Streams由使用Spring Cloud Stream库作为与底层消息传递中间件产品进行通信的基础的应用程序组成。Spring Cloud Stream还提供了来自多个供应商的中间件的固定配置,特别是提供持久的发布 - 订阅语义。

Spring Cloud Stream中的Binder抽象是将应用程序连接到中间件的原因。绑定器的几个配置属性可以跨所有绑定器实现移植,还有一些属于中间件。

对于使用者应用程序,在消息处理期间生成的异常存在重试策略。通过使用公共使用者属性 maxAttempts,backOffInitialInterval,backOffMaxInterval和backOffMultiplier 配置重试策略。这些属性的默认值重试回调方法调用3次,并等待一秒钟进行第一次重试。退避乘数2用于第二次和第三次尝试。

当重试次数超过maxAttempts值时,异常和失败的消息将成为消息的有效负载,并发送到应用程序的错误通道。默认情况下,此错误通道的默认消息处理程序会记录该消息。您可以通过创建自己的订阅错误通道的消息处理程序来更改应用程序中的默认行为。

13.流编程模型

虽然Spring Boot为创建DevOps友好的微服务应用程序提供了基础,但Spring生态系统中的其他库有助于创建基于流的微服务应用程序。其中最重要的是Spring Cloud Stream。

Spring Cloud Stream编程模型的本质是提供一种简单的方法来描述通过消息传递中间件进行通信的应用程序的多个输入和输出。这些输入和输出映射到Kafka主题或Rabbit交换和队列以及KStream / KTable编程模型。生成数据的Source,消耗和生成数据的处理器以及消耗数据的Sink的常见应用程序配置作为库的一部分提供。

13.1.命令式编程模型

Spring Cloud Stream与Spring Integration的命令式“一次一个事件”编程模型最紧密地结合在一起。这意味着您编写处理单个事件回调的代码,如以下示例所示,

@EnableBinding(Sink.class)

public class LoggingSink {

@StreamListener(Sink.INPUT)

public void log(String message) {

System.out.println(message);

}

}在这种情况下,输入通道上的消息的String有效载荷将传递给log方法。@EnableBinding注释用于将输入通道绑定到外部中间件。

13.2.功能编程模型

但是,Spring Cloud Stream可以支持其他编程样式,例如反应式API,其中传入和传出数据作为连续数据流处理,以及如何处理每个单独的消息。对于许多反应性AOI,您还可以使用描述从入站数据流到出站数据流的功能转换的运算符。这是一个例子:

@EnableBinding(Processor.class)

public static class UppercaseTransformer {

@StreamListener

@Output(Processor.OUTPUT)

public Flux<String> receive(@Input(Processor.INPUT) Flux<String> input) {

return input.map(s -> s.toUpperCase());

}

}14.应用程序版本控制

现在,在将数据流与Skipper一起使用时,现在支持在Stream中进行应用程序版本控制。您可以更新应用程序和部署属性以及应用程序的版本。还支持回滚到先前的应用程序版本。

15.任务编程模型

Spring Cloud Task编程模型提供:

-

持久化任务的生命周期事件和退出代码状态。

-

生命周期钩子在任务执行之前或之后执行代码。

-

在任务生命周期中将任务事件发送到流(作为源)的能力。

-

与Spring Batch工作集成。

有关更多信息,请参阅任务部分。

16.分析

17.运行时

数据流服务器依赖于目标平台来实现以下运行时功能:

17.1.容错

数据流支持的目标运行时都能够重新启动长期存在的应用程序。部署应用程序时,运行时环境需要Spring Cloud Data Flow设置运行状况探测器。您还可以自定义运行状况探测器。

组成流的所有应用程序的集合状态用于确定流的状态。如果应用程序失败,则流的状态将从“已部署”更改为“部分”。

17.2.资源管理

每个目标运行时都允许您控制分配给每个应用程序的内存,磁盘和CPU的数量。它们通过使用每个运行时唯一的键名称作为部署清单中的属性传递。有关更多信息,请参阅每个平台的服务器文档。

17.3.在运行时缩放

部署流时,您可以为组成流的每个应用程序设置实例计数。部署流后,每个目标运行时都允许您控制每个应用程序的目标实例数。使用每个运行时的API,UI或命令行工具,您可以根据需要向上或向下扩展实例数。

目前,Kafka绑定器以及分区流不支持运行时扩展,建议的解决方法是使用更新的实例数重新部署流。两种情况都需要根据有关总实例数和当前实例索引的信息来设置静态使用者。

组态

本节介绍如何配置Spring Cloud Data Flow服务器的功能,例如要使用的关系数据库和安全性。它还介绍了如何配置Spring Cloud Data Flow的shell功能。

18.功能切换

Sprig Cloud Data Flow Server提供了一组特定功能,可在启动时启用/禁用。这些功能包括所有生命周期操作和REST端点(服务器和客户端实现,包括shell和UI):

-

流

-

任务

-

Analytics(分析)

-

船长

-

任务计划程序

可以通过在启动数据流服务器时设置以下布尔属性来启用和禁用这些功能:

-

spring.cloud.dataflow.features.streams-enabled -

spring.cloud.dataflow.features.tasks-enabled -

spring.cloud.dataflow.features.analytics-enabled -

spring.cloud.dataflow.features.skipper-enabled -

spring.cloud.dataflow.features.schedules-enabled

默认情况下,启用流,任务和分析,默认情况下禁用Skipper和Task Scheduler。

由于默认情况下启用了分析功能,因此数据流服务器希望将有效的Redis存储作为分析存储库提供给服务器,因为Spring Cloud Data Flow提供了基于Redis的默认分析实现。这也意味着数据流服务器的health也取决于redis商店的可用性。如果您不希望Data Flow的端点读取写入Redis的分析数据,请通过设置上述属性来禁用分析功能。

|

REST /about端点提供有关已启用和禁用的功能的信息。

19.数据库

关系数据库用于存储流和任务定义以及执行任务的状态。Spring Cloud Data Flow为H2,HSQLDB,MySQL,Oracle,Postgresql,DB2和SqlServer提供模式。服务器启动时会自动创建架构。

默认情况下,Spring Cloud Data Flow提供H2数据库的嵌入式实例。H2数据库有利于开发目的,但不建议用于生产。

MySQL(通过MariaDB驱动程序),HSQLDB,PostgreSQL和嵌入式H2的JDBC驱动程序无需额外配置即可使用。如果您正在使用任何其他数据库,则需要将相应的JDBC驱动程序jar放在服务器的类路径上。

数据库属性可以作为环境变量或命令行参数传递给数据流服务器。

以下示例显示如何使用环境变量定义数据库连接:

export spring_datasource_url=jdbc:postgresql://localhost:5432/mydb

export spring_datasource_username=myuser

export spring_datasource_password=mypass

export spring_datasource_driver_class_name="org.postgresql.Driver"以下示例显示如何使用命令行参数定义MySQL数据库连接

java -jar spring-cloud-dataflow-server-local/target/spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar \

--spring.datasource.url=jdbc:mysql://localhost:3306/mydb \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=org.mariadb.jdbc.Driver & 以下示例显示如何使用命令行参数定义PostgreSQL数据库连接:

java -jar spring-cloud-dataflow-server-local/target/spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar \

--spring.datasource.url=jdbc:postgresql://localhost:5432/mydb \

--spring.datasource.username= \

--spring.datasource.password= \

--spring.datasource.driver-class-name=org.postgresql.Driver & 以下示例显示如何使用命令行参数定义HSQLDB数据库连接:

java -jar spring-cloud-dataflow-server-local/target/spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar \

--spring.datasource.url=jdbc:hsqldb://localhost:9001/mydb \

--spring.datasource.username=SA \

--spring.datasource.driver-class-name=org.hsqldb.jdbc.JDBCDriver &

如果您希望使用外部H2数据库实例而不是嵌入Spring Cloud Data Flow的实例,请将spring.dataflow.embedded.database.enabled属性设置为false。如果spring.dataflow.embedded.database.enabled设置为false或者将h2以外的数据库指定为数据源,则嵌入式数据库不会启动。

|

19.1.禁用数据库架构创建和迁移策略

您可以控制数据流是否在启动时引导数据库。在大多数生产环境中,您可能无法获得足够的权限。如果是这种情况,您可以通过将属性spring.cloud.dataflow.rdbms.initialize.enable设置为false来禁用它。可以在spring-cloud-dataflow-core/src/main/resources/文件夹下找到服务器用于引导数据库的脚本。

对于新安装,运行位于/schemas和/migrations.1.x.x下的相应数据库脚本,对于版本1.2.0的升级,您只需运行/migrations.1.x.x脚本。

19.2.添加自定义JDBC驱动程序

要为数据库添加自定义驱动程序(例如,Oracle),您应该重建数据流服务器并将依赖项添加到Maven pom.xml文件。由于每个目标平台都有一个Spring Cloud Data Flow服务器,因此您需要为每个平台修改相应的maven pom.xml。每个服务器版本的每个GitHub存储库中都有标记。

要为本地服务器实现添加自定义JDBC驱动程序依赖项:

-

选择与要重建的服务器版本对应的标记并克隆github存储库。

-

编辑spring-cloud-dataflow-server-local / pom.xml,并在

dependencies部分中添加所需数据库驱动程序的依赖项。在以下示例中,已选择Oracle驱动程序:

<dependencies>

...

<dependency>

<groupId>com.oracle.jdbc</groupId>

<artifactId>ojdbc8</artifactId>

<version>12.2.0.1</version>

</dependency>

...

</dependencies>-

构建应用程序,如构建Spring Cloud Data Flow中所述

您还可以通过向dataflow-server.yml文件添加必要的属性来重建服务器时提供默认值,如以下PostgreSQL示例所示:

spring:

datasource:

url: jdbc:postgresql://localhost:5432/mydb

username: myuser

password: mypass

driver-class-name:org.postgresql.Driver20.当地部署人员

您可以使用Data Flow Local服务器部署程序的以下配置属性来自定义应用程序的部署方式:

spring.cloud.deployer.local.workingDirectoriesRoot=java.io.tmpdir # Directory in which all created processes will run and create log files.

spring.cloud.deployer.local.deleteFilesOnExit=true # Whether to delete created files and directories on JVM exit.

spring.cloud.deployer.local.envVarsToInherit=TMP,LANG,LANGUAGE,"LC_.*. # Array of regular expression patterns for environment variables that are passed to launched applications.

spring.cloud.deployer.local.javaCmd=java # Command to run java.

spring.cloud.deployer.local.shutdownTimeout=30 # Max number of seconds to wait for app shutdown.

spring.cloud.deployer.local.javaOpts= # The Java options to pass to the JVM

spring.cloud.deployer.local.freeDiskSpacePercentage=5 # The target percentage of free disk space to always aim for when cleaning downloaded resources (typically via the local maven repository). Specify as an integer greater than zero and less than 100. Default is 5.|

数据流本地服务器本身从其默认值覆盖 |

部署应用程序时,您还可以设置以deployer.<name of application>为前缀的部署程序属性。例如,要在ticktock流中为时间应用程序设置Java选项,请使用以下流部署属性。

dataflow:> stream create --name ticktock --definition "time --server.port=9000 | log"

dataflow:> stream deploy --name ticktock --properties "deployer.time.local.javaOpts=-Xmx2048m -Dtest=foo"为方便起见,您可以设置deployer.memory属性以设置Java选项-Xmx,如以下示例所示:

dataflow:> stream deploy --name ticktock --properties "deployer.time.memory=2048m"在部署时,如果在deployer.<app>.local.javaOpts属性中指定-Xmx选项以及deployer.<app>.local.memory选项的值,则javaOpts属性中的值具有优先权。此外,部署应用程序时设置的javaOpts属性优先于数据流服务器的spring.cloud.deployer.local.javaOpts属性。

21. Maven

如果要覆盖特定的maven配置属性(远程存储库,代理和其他)或在代理后面运行数据流服务器,则需要在启动数据流服务器时将这些属性指定为命令行参数,如下所示例:

$ java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar --maven.localRepository=mylocal

--maven.remote-repositories.repo1.url=https://repo1

--maven.remote-repositories.repo1.auth.username=user1

--maven.remote-repositories.repo1.auth.password=pass1

--maven.remote-repositories.repo1.snapshot-policy.update-policy=daily

--maven.remote-repositories.repo1.snapshot-policy.checksum-policy=warn

--maven.remote-repositories.repo1.release-policy.update-policy=never

--maven.remote-repositories.repo1.release-policy.checksum-policy=fail

--maven.remote-repositories.repo2.url=https://repo2

--maven.remote-repositories.repo2.policy.update-policy=always

--maven.remote-repositories.repo2.policy.checksum-policy=fail

--maven.proxy.host=proxy1

--maven.proxy.port=9010 --maven.proxy.auth.username=proxyuser1

--maven.proxy.auth.password=proxypass1默认情况下,协议设置为http。如果代理不需要用户名和密码,则可以省略auth属性。此外,maven localRepository默认设置为${user.home}/.m2/repository/。如前面的示例所示,可以指定远程存储库及其身份验证(如果需要)。如果远程存储库位于代理后面,则可以指定代理属性,如上例所示。

可以为每个远程存储库配置指定存储库策略,如上例所示。密钥policy适用于snapshot和release存储库策略。

您可以参考Repository策略以获取支持的存储库策略列表。

由于它们是Spring Boot @ConfigurationProperties,您还可以将它们指定为环境变量,例如MAVEN_REMOTE_REPOSITORIES_REPO1_URL。另一个常见选项是通过设置SPRING_APPLICATION_JSON环境变量来设置属性。以下示例显示了JSON的结构:

$ SPRING_APPLICATION_JSON='{ "maven": { "local-repository": null,

"remote-repositories": { "repo1": { "url": "https://repo1", "auth": { "username": "repo1user", "password": "repo1pass" } }, "repo2": { "url": "https://repo2" } },

"proxy": { "host": "proxyhost", "port": 9018, "auth": { "username": "proxyuser", "password": "proxypass" } } } }' java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar22.本地数据流服务器日志记录配置

Spring Cloud Data Flow local服务器配置为使用RollingFileAppender进行日志记录。

logging: config: classpath:logback-scdf-local.xml

默认情况下,日志文件配置为使用:

<property name="LOG_FILE" value="${LOG_FILE:-${LOG_PATH:-${LOG_TEMP:-${java.io.tmpdir:-/tmp}}}/spring-cloud-dataflow-server-local}"/>使用RollingPolicy的logback配置:

<appender name="FILE"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_FILE}.log</file>

<rollingPolicy

class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<!-- daily rolling -->

<fileNamePattern>${LOG_FILE}.${LOG_FILE_ROLLING_FILE_NAME_PATTERN:-%d{yyyy-MM-dd}}.%i.gz</fileNamePattern>

<maxFileSize>${LOG_FILE_MAX_SIZE:-100MB}</maxFileSize>

<maxHistory>${LOG_FILE_MAX_HISTORY:-30}</maxHistory>

<totalSizeCap>${LOG_FILE_TOTAL_SIZE_CAP:-500MB}</totalSizeCap>

</rollingPolicy>

<encoder>

<pattern>${FILE_LOG_PATTERN}</pattern>

</encoder>

</appender>

要检查当前Spring Cloud Data Flow服务器local服务器的java.io.tmpdir,

jinfo <pid> | grep "java.io.tmpdir"如果您想更改或覆盖任何属性LOG_FILE,LOG_PATH,LOG_TEMP,LOG_FILE_MAX_SIZE,LOG_FILE_MAX_HISTORY和LOG_FILE_TOTAL_SIZE_CAP,请将它们设置为系统属性。

23.船长

要使用Stream更新和回滚等功能,Data Flow Server会委托Skipper服务器来管理Stream的生命周期。将配置属性spring.cloud.skipper.client.serverUri设置为Skipper的位置,例如

+

$ java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar --spring.cloud.skipper.client.serverUri=http://192.51.100.1:7577/api --spring.cloud.dataflow.features.skipper-enabled=true24.安全

默认情况下,数据流服务器是不安全的,并在未加密的HTTP连接上运行。您可以通过启用HTTPS并要求客户端使用以下任一方法进行身份验证来保护您的REST端点以及数据流仪表板:

-

传统认证(包括基本认证)

下图显示了Spring Cloud Data Flow服务器的身份验证选项:

选择传统身份验证时,Spring Cloud Data Flow服务器是主要身份验证点,使用Spring Security。选择此选项后,用户需要通过选择所需的身份验证后备存储来进一步定义其首选身份验证机制,该存储可以是以下选项之一:

在传统身份验证或OAuth2之间进行选择时,请记住这两个选项是互斥的。有关更详细的讨论,请参阅以下部分。

|

默认情况下,REST端点(管理,管理和运行状况)以及仪表板UI不需要经过身份验证的访问。 |

24.1.启用HTTPS

默认情况下,仪表板,管理和运行状况端点使用HTTP作为传输。您可以通过在application.yml中为配置添加证书来切换到HTTPS,如以下示例所示:

server:

port: 8443 (1)

ssl:

key-alias: yourKeyAlias (2)

key-store: path/to/keystore (3)

key-store-password: yourKeyStorePassword (4)

key-password: yourKeyPassword (5)

trust-store: path/to/trust-store (6)

trust-store-password: yourTrustStorePassword (7)| 1 | 由于默认端口为9393,您可以选择将端口更改为更常见的HTTPs典型端口。 |

| 2 | 密钥存储在密钥库中的别名(或名称)。 |

| 3 | 密钥库文件的路径。也可以使用类路径前缀指定类路径资源 - 例如:classpath:path/to/keystore。 |

| 4 | 密钥库的密码。 |

| 5 | 密钥的密码。 |

| 6 | 信任库文件的路径。也可以使用类路径前缀指定类路径资源 - 例如:classpath:path/to/trust-store |

| 7 | 信任存储的密码。 |

| 如果启用了HTTPS,它将完全替换HTTP作为REST端点和数据流仪表板交互的协议。普通HTTP请求将失败。因此,请确保相应地配置Shell。 |

24.1.1.使用自签名证书

出于测试目的或在开发期间,创建自签名证书可能会很方便。要开始,请执行以下命令以创建证书:

$ keytool -genkey -alias dataflow -keyalg RSA -keystore dataflow.keystore \

-validity 3650 -storetype JKS \

-dname "CN=localhost, OU=Spring, O=Pivotal, L=Kailua-Kona, ST=HI, C=US" (1)

-keypass dataflow -storepass dataflow| 1 | CN是这里的重要参数。它应该与您尝试访问的域匹配 - 例如,localhost。 |

然后将以下行添加到application.yml文件中:

server:

port: 8443

ssl:

enabled: true

key-alias: dataflow

key-store: "/your/path/to/dataflow.keystore"

key-store-type: jks

key-store-password: dataflow

key-password: dataflow这就是数据流服务器所需的全部内容。启动服务器后,您应该能够在localhost:8443/访问它。由于这是一个自签名证书,您应该在浏览器中发出警告,您需要忽略该警告。

24.1.2.自签证书和壳牌

默认情况下,自签名证书是shell的问题,并且必须执行其他步骤才能使shell使用自签名证书。有两种选择:

-

将自签名证书添加到JVM信任库。

-

跳过证书验证。

将自签名证书添加到JVM信任库

为了使用JVM信任库选项,我们需要从密钥库导出以前创建的证书,如下所示:

$ keytool -export -alias dataflow -keystore dataflow.keystore -file dataflow_cert -storepass dataflow接下来,我们需要创建一个shell可以使用的信任库,如下所示:

$ keytool -importcert -keystore dataflow.truststore -alias dataflow -storepass dataflow -file dataflow_cert -noprompt现在,您已准备好使用以下JVM参数启动数据流Shell:

$ java -Djavax.net.ssl.trustStorePassword=dataflow \

-Djavax.net.ssl.trustStore=/path/to/dataflow.truststore \

-Djavax.net.ssl.trustStoreType=jks \

-jar spring-cloud-dataflow-shell-1.7.3.RELEASE.jar|

如果您在通过SSL建立连接时遇到问题,可以通过使用 |

不要忘记使用以下内容定位数据流服务器:

dataflow:> dataflow config server https://localhost:8443/跳过证书验证

或者,您也可以通过提供可选的命令行参数--dataflow.skip-ssl-validation=true来绕过认证验证。

如果设置此命令行参数,则shell将接受任何(自签名)SSL证书。

|

如果可能,您应该避免使用此选项。禁用信任管理器会破坏SSL的目的,使您容易受到中间人攻击。 |

24.2.传统认证

使用传统身份验证时,Spring Cloud Data Flow是唯一的身份验证提供程序。在这种情况下,Data Flow REST API用户将使用 基本身份验证 来访问端点。

使用该选项时,用户可以选择三个后备存储来获取身份验证详细信息:

-

通过设置Spring Boot属性进行单用户身份验证

-

使用Yaml文件为多个用户进行基于文件的身份验证

-

Ldap身份验证

24.2.1.单用户身份验证

这是最简单的选项,可模拟默认Spring Boot用户体验的行为。可以通过设置环境变量或将以下内容添加到application.yml来启用它:

security:

basic:

enabled: true (1)

realm: Spring Cloud Data Flow (2)| 1 | 启用基本身份验证。必须设置为true才能启用安全性。 |

| 2 | (可选)基本身份验证的领域。如果没有明确设置,则默认为Spring。 |

| 当前版本的Chrome不显示该领域。有关更多信息,请参阅以下 Chromium问题单。 |

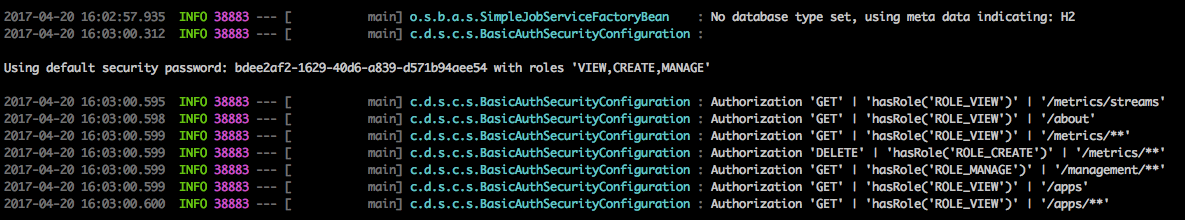

在此用例中,底层Spring Boot使用自动生成的密码自动创建名为user的用户,该密码在启动时打印到控制台。

使用此设置,生成的用户将分配所有主要角色,如下所示:

-

视图

-

创建

-

管理

下图显示了控制台中显示的默认Spring Boot用户凭据。

您可以通过设置以下属性来自定义用户:

security.user.name=user # Default user name.

security.user.password= # Password for the default user name. A random password is logged on startup by default.

security.user.role=VIEW,CREATE,MANAGE # Granted roles for the default user name.| 请注意基本身份验证和注销的固有问题:浏览器缓存凭据,只需浏览到应用程序页面即可重新登录。 |

当然,您也可以通过设置系统属性,环境变量或命令行参数来传递凭据,因为这是标准的Spring Boot行为。例如,在以下示例中,命令行参数用于指定用户凭据:

$ java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar\

--security.basic.enabled=true \

--security.user.name=test \

--security.user.password=pass \

--security.user.role=VIEW如果您需要定义多个基于文件的用户帐户,请查看基于文件的身份验证。

24.2.2.基于文件的身份验证

默认情况下,Spring Boot允许您仅指定一个用户。Spring Cloud数据流还支持在配置文件中列出多个用户。必须为每个用户分配密码和一个或多个角色。以下示例显示了其他用户的创建:

security:

basic:

enabled: true

realm: Spring Cloud Data Flow

spring:

cloud:

dataflow:

security:

authentication:

file:

enabled: true (1)

users: (2)

bob: bobspassword, ROLE_MANAGE (3)

alice: alicepwd, ROLE_VIEW, ROLE_CREATE| 1 | 启用基于文件的身份验证。 |

| 2 | 这是用户名到密码的yaml地图。 |

| 3 | 每个映射value由相应的密码和角色组成,以逗号分隔。 |

24.2.3.LDAP身份验证

Spring Cloud Data Flow还支持对LDAP(轻量级目录访问协议)服务器的身份验证,为以下模式提供支持:

-

直接绑定

-

搜索并绑定

激活LDAP身份验证选项后,将关闭默认的单用户模式。

在直接绑定模式下,使用用户名的占位符为用户的可分辨名称(DN)定义模式。身份验证过程通过替换占位符并使用它来针对LDAP服务器对用户进行身份验证以及提供的密码来派生用户的可分辨名称。您可以按如下方式设置LDAP直接绑定:

security:

basic:

enabled: true

realm: Spring Cloud Data Flow

spring:

cloud:

dataflow:

security:

authentication:

ldap:

enabled: true (1)

url: ldap://ldap.example.com:3309 (2)

userDnPattern: uid={0},ou=people,dc=example,dc=com (3)| 1 | 启用LDAP身份验证 |

| 2 | LDAP服务器的URL |

| 3 | 用于对服务器进行身份验证的可分辨名称(DN)模式 |

搜索和绑定模式涉及以匿名方式或使用固定帐户连接到LDAP服务器,根据用户名搜索身份验证用户的可分辨名称,然后使用结果值和提供的密码绑定到LDAP服务器。此选项配置如下:

security:

basic:

enabled: true

realm: Spring Cloud Data Flow

spring:

cloud:

dataflow:

security:

authentication:

ldap:

enabled: true (1)

url: ldap://localhost:10389 (2)

managerDn: uid=admin,ou=system (3)

managerPassword: secret (4)

userSearchBase: ou=otherpeople,dc=example,dc=com (5)

userSearchFilter: uid={0} (6)| 1 | 启用LDAP集成 |

| 2 | LDAP服务器的URL |

| 3 | 如果不支持匿名搜索,则对LDAP服务器进行身份验证的DN(可选,需要与下一个选项一起使用) |

| 4 | 如果不支持匿名搜索,则为LDAP服务器进行身份验证的密码(可选,与先前选项一起使用) |

| 5 | 搜索身份验证用户DN的基础(用于限制搜索范围) |

| 6 | 验证用户的DN的搜索过滤器 |

| 有关详细信息,另请参阅 Spring Security参考指南的 LDAP身份验证章节。 |

LDAP角色映射

默认情况下,从Ldap检索的角色名称需要与Spring Cloud Data Flow中角色的名称匹配。但是,也可以显式提供LDAP角色和Spring Cloud Data Flow角色之间的映射。

security:

basic:

enabled: true

realm: Spring Cloud Data Flow

spring:

cloud:

dataflow:

security:

authentication:

ldap:

enabled: true

url: ldap://localhost:10389

managerDn: uid=admin,ou=system

managerPassword: secret

userSearchBase: ou=otherpeople,dc=example,dc=com

userSearchFilter: uid={0}

roleMappings: (1)

ROLE_MANAGE: foo-manage (2)

ROLE_VIEW: bar-view

ROLE_CREATE: foo-manage| 1 | 启用显式角色映射支持 |

| 2 | 启用角色映射支持后,必须为所有3个Spring Cloud Data Flow角色ROLE_MANAGE,ROLE_VIEW,ROLE_CREATE提供映射。 |

LDAP传输安全性

连接到LDAP服务器时,通常(在LDAP世界中)有两个选项可以安全地建立与LDAP服务器的连接:

-

LDAP over SSL(LDAPs)

-

启动传输层安全性(启动TLS在RFC2830中定义)

从Spring Cloud Data Flow 1.1.0开始,只支持开箱即用的LDAP。使用官方证书时,无需通过LDAP连接LDAP服务器进行特殊配置。您只需将url格式更改为ldaps - 例如:ldaps://localhost:636。

对于自签名证书,Spring Cloud Data Flow服务器的设置会稍微复杂一些。该设置与使用自签名证书非常相似 (请先阅读),Spring Cloud Data Flow需要引用trustStore才能使用自签名证书。

| 虽然在开发和测试期间很有用,但永远不要在生产中使用自签名证书! |

最终,您必须提供一组系统属性,以便在启动服务器时引用trustStore及其凭据,如下所示:

$ java -Djavax.net.ssl.trustStorePassword=dataflow \

-Djavax.net.ssl.trustStore=/path/to/dataflow.truststore \

-Djavax.net.ssl.trustStoreType=jks \

-jar spring-cloud-starter-dataflow-server-local-1.7.3.RELEASE.jar如前所述,安全连接到LDAP服务器的另一个选项是Start TLS。在LDAP世界中,技术上甚至认为LDAP不赞成使用Start TLS。但是,Spring Cloud Data Flow目前不支持此选项。

请按照以下问题跟踪器票据来跟踪其实施情况。您可能还需要查看有关自定义DirContext身份验证处理的Spring LDAP参考文档章节以 获取更多详细信息。

24.2.4.Shell身份验证

使用传统身份验证与数据流Shell时,通常使用命令行参数提供用户名和密码,如以下示例所示:

$ java -jar target/spring-cloud-dataflow-shell-1.7.3.RELEASE.jar \

--dataflow.username=myuser \ (1)

--dataflow.password=mysecret (2)| 1 | 如果启用了身份验证,则必须提供用户名。 |

| 2 | 如果未提供密码,则shell会提示输入密码。 |

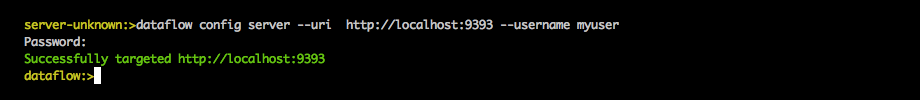

或者,您也可以从shell中定位数据流服务器,如下所示:

server-unknown:>dataflow config server

--uri http://localhost:9393 \ (1)

--username myuser \ (2)

--password mysecret \ (3)

--skip-ssl-validation true \ (4)| 1 | 可选,默认为localhost:9393。 |

| 2 | 如果启用安全性,则必须提供。 |

| 3 | 如果启用了安全性,并且未提供密码,则会提示用户输入密码。 |

| 4 | 可选,忽略证书错误(使用自签名证书时)。谨慎使用! |

下图显示了连接和验证数据流服务器的典型shell命令:

24.2.5.自定义授权

前面的内容涉及身份验证 - 即如何评估用户的身份。无论选择何种选项,您还可以自定义授权 - 即谁可以做什么。

默认方案使用三个角色来保护 Spring Cloud Data Flow公开的REST端点:

-

ROLE_VIEW用于检索状态的任何内容

-

任何涉及创建,删除或改变系统状态的ROLE_CREATE

-

ROLE_MANAGE用于启动管理端点

所有这些默认值都在dataflow-server-defaults.yml中指定,它是Spring Cloud Data Flow核心模块的一部分。尽管如此,如果需要,您可以覆盖它们 - 例如,在application.yml中。配置采用YAML列表的形式(因为某些规则可能优先于其他规则)。因此,您需要复制并粘贴整个列表并根据您的需要进行定制(因为无法合并列表)。

请始终参考您的application.yml版本,因为以下代码段可能已过时。

|

默认规则如下:

spring:

cloud:

dataflow:

security:

authorization:

enabled: true

rules:

# Metrics

- GET /metrics/streams => hasRole('ROLE_VIEW')

# About

- GET /about => hasRole('ROLE_VIEW')

# Metrics

- GET /metrics/** => hasRole('ROLE_VIEW')

- DELETE /metrics/** => hasRole('ROLE_CREATE')

# Boot Endpoints

- GET /management/** => hasRole('ROLE_MANAGE')

# Apps

- GET /apps => hasRole('ROLE_VIEW')

- GET /apps/** => hasRole('ROLE_VIEW')

- DELETE /apps/** => hasRole('ROLE_CREATE')

- POST /apps => hasRole('ROLE_CREATE')

- POST /apps/** => hasRole('ROLE_CREATE')

# Completions

- GET /completions/** => hasRole('ROLE_CREATE')

# Job Executions & Batch Job Execution Steps && Job Step Execution Progress

- GET /jobs/executions => hasRole('ROLE_VIEW')

- PUT /jobs/executions/** => hasRole('ROLE_CREATE')

- GET /jobs/executions/** => hasRole('ROLE_VIEW')

# Batch Job Instances

- GET /jobs/instances => hasRole('ROLE_VIEW')

- GET /jobs/instances/* => hasRole('ROLE_VIEW')

# Running Applications

- GET /runtime/apps => hasRole('ROLE_VIEW')

- GET /runtime/apps/** => hasRole('ROLE_VIEW')

# Stream Definitions

- GET /streams/definitions => hasRole('ROLE_VIEW')

- GET /streams/definitions/* => hasRole('ROLE_VIEW')

- GET /streams/definitions/*/related => hasRole('ROLE_VIEW')

- POST /streams/definitions => hasRole('ROLE_CREATE')

- DELETE /streams/definitions/* => hasRole('ROLE_CREATE')

- DELETE /streams/definitions => hasRole('ROLE_CREATE')

# Stream Deployments

- DELETE /streams/deployments/* => hasRole('ROLE_CREATE')

- DELETE /streams/deployments => hasRole('ROLE_CREATE')

- POST /streams/deployments/* => hasRole('ROLE_CREATE')

# Stream Validations

- GET /streams/validation/ => hasRole('ROLE_VIEW')

- GET /streams/validation/* => hasRole('ROLE_VIEW')

# Task Definitions

- POST /tasks/definitions => hasRole('ROLE_CREATE')

- DELETE /tasks/definitions/* => hasRole('ROLE_CREATE')

- GET /tasks/definitions => hasRole('ROLE_VIEW')

- GET /tasks/definitions/* => hasRole('ROLE_VIEW')

# Task Executions

- GET /tasks/executions => hasRole('ROLE_VIEW')

- GET /tasks/executions/* => hasRole('ROLE_VIEW')

- POST /tasks/executions => hasRole('ROLE_CREATE')

- DELETE /tasks/executions/* => hasRole('ROLE_CREATE')

# Task Schedules

- GET /tasks/schedules => hasRole('ROLE_VIEW')

- GET /tasks/schedules/* => hasRole('ROLE_VIEW')

- POST /tasks/schedules => hasRole('ROLE_CREATE')

- DELETE /tasks/schedules/* => hasRole('ROLE_CREATE')

# Task Validations

- GET /tasks/validation/ => hasRole('ROLE_VIEW')

- GET /tasks/validation/* => hasRole('ROLE_VIEW')

# Tools

- POST /tools/** => hasRole('ROLE_CREATE')每行的格式如下:

HTTP_METHOD URL_PATTERN '=>' SECURITY_ATTRIBUTE

哪里

-

HTTP_METHOD是一种http方法,大写情况

-

URL_PATTERN是一种Ant样式的URL模式

-

SECURITY_ATTRIBUTE是一个SpEL表达式。请参阅基于表达式的访问控制。

-

每个由一个或几个空白字符(空格,制表符等)分隔的字符串

请注意,上面确实是一个YAML列表,而不是一个映射(因此在每行的开头使用' - '破折号),它位于spring.cloud.dataflow.security.authorization.rules键下。

|

如果您只对身份验证感兴趣而不是授权(例如,每个用户都可以访问所有端点),那么您也可以设置 |

如果通过设置安全性属性来使用基本安全性配置,则为用户设置角色很重要,如以下示例所示:

java -jar spring-cloud-dataflow-server-local/target/spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar \

--security.basic.enabled=true \

--security.user.name=test \

--security.user.password=pass \

--security.user.role=VIEW24.2.6.授权 - Shell和Dashboard行为

启用授权后,仪表板和shell将具有角色感知功能,这意味着,根据分配的角色,并非所有功能都可见。

例如,用户没有必要角色的shell命令被标记为不可用。

|

目前,shell的 |

同样,对于仪表板,UI不显示未授权用户的页面或页面元素。

24.2.7.使用LDAP授权

配置LDAP进行身份验证时,您还可以将group-role-attribute与group-search-base和group-search-filter一起指定。

组角色属性包含角色的名称。如果未指定,则默认填充ROLE_MANAGE角色。

有关详细信息,请参阅Spring Security参考指南中的配置LDAP服务器。

24.3.OAuth 2.0

OAuth 2.0允许您将Spring Cloud数据流集成到单点登录(SSO)环境中。使用以下OAuth2授权类型:

-

授权码:用于GUI(浏览器)集成。访问者将重定向到您的OAuth服务以进行身份验证

-

密码:由shell(以及REST集成)使用,因此访问者可以使用用户名和密码登录

-

客户端凭据:直接从OAuth提供程序检索访问令牌,并使用Authorization HTTP标头将其传递到数据流服务器

可以通过两种方式访问REST端点:

-

基本身份验证,使用封面下的密码授予类型对您的OAuth2服务进行身份验证

-

访问令牌,使用封面下的客户端凭据授予类型

| 设置身份验证时,强烈建议您也启用HTTPS,尤其是在生产环境中。 |

您可以通过将以下内容添加到application.yml或通过设置环境变量来启用OAuth2身份验证:

security:

oauth2:

client:

client-id: myclient (1)

client-secret: mysecret

access-token-uri: http://127.0.0.1:9999/oauth/token

user-authorization-uri: http://127.0.0.1:9999/oauth/authorize

resource:

user-info-uri: http://127.0.0.1:9999/me| 1 | 在OAuth配置部分中提供客户端ID可激活OAuth2安全性 |

您可以使用curl验证基本身份验证是否正常工作,如下所示:

$ curl -u myusername:mypassword http://localhost:9393/ -H 'Accept: application/json'因此,您应该看到可用REST端点的列表。

请注意,使用web浏览器访问根URL并启用安全性时,您将被重定向到仪表板UI。要查看REST端点列表,请指定application/json。另外,请务必使用Postman(Chrome)或RESTClient(Firefox)等工具添加Accept标头。

|

除基本身份验证外,您还可以提供访问令牌以访问REST Api。为了实现这一点,您首先要从OAuth2提供程序检索OAuth2访问令牌,然后使用Authorization Http标头将该访问令牌传递给REST Api :

$ curl -H "Authorization: Bearer <ACCESS_TOKEN>" http://localhost:9393/ -H 'Accept: application/json'24.3.1.OAuth REST端点授权

OAuth2身份验证选项使用与传统身份验证选项相同的授权规则 。

|

授权规则在 |

由于安全角色的确定是特定于环境的,因此默认情况下,Spring Cloud Data Flow会使用DefaultDataflowAuthoritiesExtractor类将所有角色分配给经过身份验证的OAuth2用户。

您可以通过提供扩展Spring Security OAuth的AuthoritiesExtractor接口的自己的Spring bean定义来自定义该行为。在这种情况下,自定义bean定义优先于Spring Cloud Data Flow提供的默认定义。

24.3.2.使用Spring Cloud Data Flow Shell进行OAuth身份验证

使用命令行管理程序时,可以通过用户名和密码或通过指定credentials-provider命令来提供凭据。

如果您的OAuth2提供程序支持密码授予类型,则可以使用以下命令启动 数据流Shell:

$ java -jar spring-cloud-dataflow-shell-1.7.3.RELEASE.jar \

--dataflow.uri=http://localhost:9393 \

--dataflow.username=my_username --dataflow.password=my_password| 请记住,启用Spring Cloud Data Flow身份验证后,如果要通过用户名/密码身份验证使用命令行管理程序,则底层OAuth2提供程序必须支持密码 OAuth2授权类型。 |

在数据流Shell中,您还可以使用以下命令提供凭据:

dataflow config server --uri http://localhost:9393 --username my_username --password my_password成功定位后,您应该看到以下输出:

dataflow:>dataflow config info

dataflow config info

╔═══════════╤═══════════════════════════════════════╗

║Credentials│[username='my_username, password=****']║

╠═══════════╪═══════════════════════════════════════╣

║Result │ ║

║Target │http://localhost:9393 ║

╚═══════════╧═══════════════════════════════════════╝或者,您可以指定credentials-provider命令以直接传入承载令牌,而不是提供用户名和密码。这可以在shell中运行,也可以在启动Shell时提供--dataflow.credentials-provider-command命令行参数。

|

使用credentials-provider命令时,请注意您的指定命令必须返回Bearer令牌(以Bearer为前缀的访问令牌)。例如,在Unix环境中,可以使用以下简单命令: |

24.3.3.OAuth2身份验证示例

本节提供以下身份验证示例:

本地OAuth2服务器

使用Spring Security OAuth,您可以使用以下简单注释轻松创建自己的OAuth2服务器:

-

@EnableResourceServer -

@EnableAuthorizationServer

可以在以下位置找到工作示例应用程序:

克隆项目并使用相应的客户端ID和客户端密钥配置Spring Cloud数据流。然后构建并启动项目。

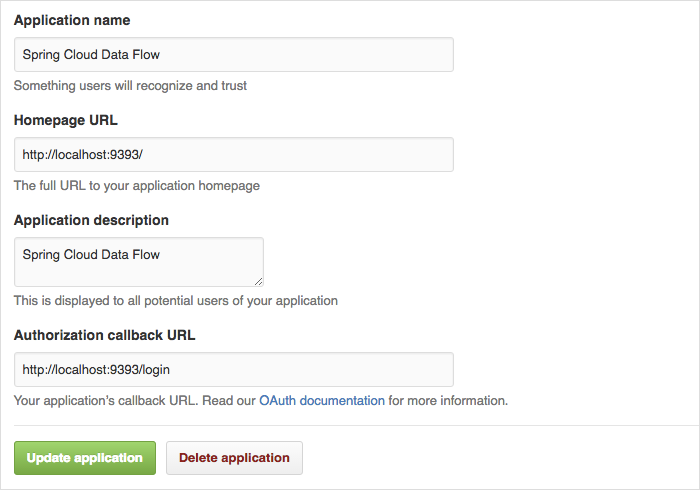

使用GitHub进行身份验证

如果您想使用现有的OAuth2提供程序,以下是GitHub的示例。首先,您需要在GitHub帐户下注册一个新的应用程序:

在本地运行默认版本的Spring Cloud Data Flow时,您的GitHub配置应如下图所示:

对于授权回调URL,请输入Spring Cloud Data Flow的登录URL - 例如,localhost:9393/login。

|

使用GitHub相关的客户端ID和密钥配置Spring Cloud Data Flow,如下所示:

security:

oauth2:

client:

client-id: your-github-client-id

client-secret: your-github-client-secret

access-token-uri: https://github.com/login/oauth/access_token

user-authorization-uri: https://github.com/login/oauth/authorize

resource:

user-info-uri: https://api.github.com/user| GitHub不支持OAuth2密码授予类型。因此,您不能将Spring Cloud Data Flow Shell与GitHub结合使用。 |

24.4.保护Spring Boot管理端点

启用安全性时,还请确保Spring Boot HTTP管理端点

也是安全的。您可以通过将以下内容添加到application.yml来为管理端点启用安全性:

management:

contextPath: /management

security:

enabled: true

如果未明确启用管理端点的安全性,则最终可能会有不安全的REST端点,尽管security.basic.enabled设置为true。

|

25.监测和管理

Spring Cloud Data Flow服务器是Spring Boot 1.5应用程序,包括Actuator库,它添加了几个生产就绪功能,以帮助您监视和管理您的应用程序。

Actuator库在上下文路径/management下添加HTTP端点,这是可用管理端点的发现页面。例如,有一个显示应用程序运行状况信息的health端点和一个列出Spring ConfigurableEnvironment属性的env。默认情况下,只能访问运行状况和应用程序信息端点。其他端点被认为是敏感的,需要通过配置明确启用。如果启用敏感端点,则还应保护数据流服务器的端点,以便不会无意中向未经身份验证的用户公开信息。默认情况下,本地数据流服务器已禁用安全性,因此所有执行器端点均可用。

数据流服务器需要关系数据库,如果启用了分析功能切换,则还需要Redis服务器。如果需要,数据流服务器会自动配置DataSourceHealthIndicator和RedisHealthIndicator。这两个服务的运行状况通过health端点合并到服务器的整体运行状况。

25.1.监控已部署的流应用程序

Spring Cloud Data Flow部署的流应用程序可以基于Spring Boot 1.5或Spring Boot 2.0。两个版本都包含几个用于监视生产中的应用程序的功能 但是,Spring Boot 1.x和2.x以及Spring Cloud Stream 1.x和2.x在实施监控方面存在差异。由于Spring Cloud Data Flow支持部署1.x和2.x应用程序,因此我们将单独介绍这两种情况。

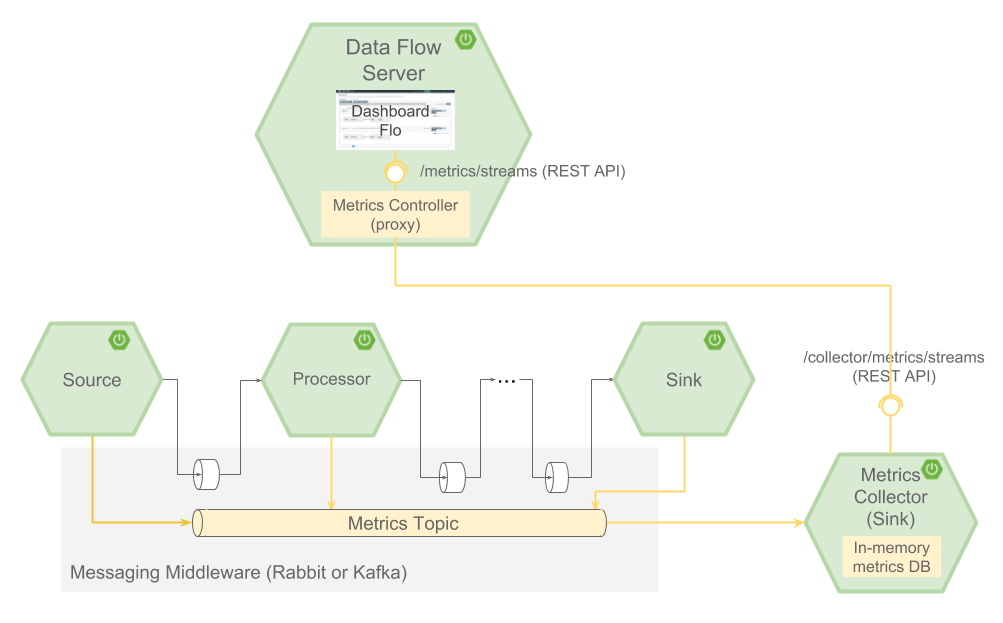

1.x和2.x应用程序的共同点是Spring Cloud Stream应用程序可以配置为将度量标准发布到消息传递中间件目标。的Spring Cloud Data Flow度量收集器所预订到该目标并聚集度量成基于流的图。Metrics Collector 2.0服务器支持从仅包含Boot 1.x或2.x应用程序的流以及包含Boot版本混合的流中收集度量标准。数据流UI通过HTTP查询Metrics收集器,以显示每个已部署应用程序旁边的消息速率。

下图显示了使用Spring Cloud Stream度量标准发布者,度量标准收集器和数据流服务器时的体系结构:

25.1.1.使用Metrics Collector

Metrics Collector有两个版本,一个基于Spring Boot 1.0的1.0版本,它了解如何聚合来自Spring Boot 1.x应用程序的指标和基于Spring Boot 2.0的2.0版本,它们了解如何聚合来自Spring Boot 1.x和2.x的指标。Rabbit和Kafka有一个Metrics Collector服务器。您可以在其项目页面上找到有关下载和运行Metrics Collector的更多信息。

数据流服务器属性:spring.cloud.dataflow.metrics.collector.uri引用Metrics Collector的URI。例如,如果在端口8080上本地运行Metrics Collector,则启动本地数据流服务器以引用Metrics Collector。

$ java -jar spring-cloud-dataflow-server-local-1.7.3.RELEASE.jar --spring.cloud.dataflow.metrics.collector.uri=http://localhost:8080可以使用需要用户名和密码的“基本”身份验证来保护Metrics Collector。要设置用户名和密码,请在启动数据流服务器时使用属性spring.cloud.dataflow.metrics.collector.username和spring.cloud.dataflow.metrics.collector.password。

设置属性spring.cloud.stream.bindings.applicationMetrics.destination时,将发布每个应用程序的度量标准。使用目标名称metrics是一个不错的选择,因为Metrics Collector默认订阅该名称。

由于希望Data Flow部署的所有流应用程序都能发出指标,因此设置属性非常普遍:

spring.cloud.dataflow.applicationProperties.stream.spring.cloud.stream.bindings.applicationMetrics.destination=metrics在Data Flow服务器上,您可以在一个中心位置配置对度量标准发布的支持。

使用目标名称metrics是一个不错的选择,因为Metrics Collector默认订阅该名称,当然,可以根据需要将其覆盖为与默认值不同。

配置度量目标的下一个最常用方法是使用部署属性。以下示例显示了使用App Starters time和log应用程序的ticktock流:

app register --name time --type source --uri maven://org.springframework.cloud.stream.app:time-source-rabbit:1.2.0.RELEASE

app register --name log --type sink --uri maven://org.springframework.cloud.stream.app:log-sink-rabbit:1.2.0.RELEASE

stream create --name foostream --definition "time | log"

stream deploy --name foostream --properties "app.*.spring.cloud.stream.bindings.applicationMetrics.destination=metrics"Metrics Collector以JSON格式公开HTTP端点/collector/metrics下的聚合度量标准。数据流服务器以两种不同的方式访问此端点。第一种是通过公开/metrics/streams HTTP端点作为Metrics Collector端点的代理。当在SCDF的Flo上覆盖消息速率时,UI可以访问它,它是流媒体管道的可视化表示。还可以通过带有消息速率的runtime apps命令来访问Runtime选项卡和shell中公开的数据流/runtime/apps端点。

下图显示了在UI的Streams选项卡中显示的消息速率:

部署应用程序时,数据流设置spring.cloud.stream.metrics.properties属性,如以下示例所示:

spring.cloud.stream.metrics.properties=spring.application.name,spring.application.index,spring.cloud.application.*,spring.cloud.dataflow.*这些键的值用作执行聚合的标记。对于2.x应用程序,这些键值直接映射到Micrometer库中的标签。属性spring.cloud.application.guid可用于跟踪生成度量标准的特定应用程序实例。guid值取决于平台。

数据流还设置用于控制导出哪些度量标准值的应用程序属性。对于1.x应用程序,属性为spring.metrics.export.triggers.application.includes,默认值如下所示:

spring.metrics.export.triggers.application.includes=integration**对于2.x应用程序,属性为spring.cloud.stream.metrics.meter-filter且没有默认值,因此将导出所有度量标准。

请注意,数据流UI仅显示瞬时输入和输出通道消息速率。数据流不提供自己的实现来存储和可视化历史指标数据,而是与现有的监控系统集成。对于Boot 1.x,支持将度量标准发送到应用程序日志和Datadog。对于Boot 2.x,指标由Micrometer库提供支持,Micrometer库提供各种监控系统。

25.1.2.Spring Boot 2.x

我们开发了一个示例应用程序,展示如何使用千分尺库修改time和log应用程序并将指标导出到InfluxDB。还提供Grafana前端。这是一个WIP,因此请查看Spring Cloud Data Flow Samples Repository以获取最新状态。

25.1.3.Spring Boot 1.x

每个部署的应用程序都包含web端点,用于监视流和任务应用程序并与之交互。

特别是,/metrics 端点包含HTTP请求的计数器和计量器,系统度量标准,如JVM统计信息,数据源度量标准和消息通道度量标准。Spring Boot允许您通过注册PublicMetrics接口的实现或通过与Dropwizard的集成将您自己的度量添加到/metrics端点。

Spring Boot接口MetricWriter和Exporter用于将度量数据发送到可以显示和分析它们的位置。Spring Boot中有实现将指标导出到Redis,Open TSDB,Statsd和JMX。

一些额外的Spring项目支持将度量数据发送到外部系统:

-

Spring Cloud Data Flow Metrics提供写入日志的

LogMetricWriter。 -

Spring Cloud Data Flow Metrics Datadog Metrics提供写入Datadog的

DatadogMetricWriter。

要使用此功能,您需要构建Stream应用程序,并使用您要使用的MetricWriter实现的附加pom依赖项。要自定义“开箱即用”流应用程序,请使用Spring Cloud Stream Initializr生成项目,然后修改pom。Data Flow Metrics项目页面上的文档提供了入门所需的其他信息。

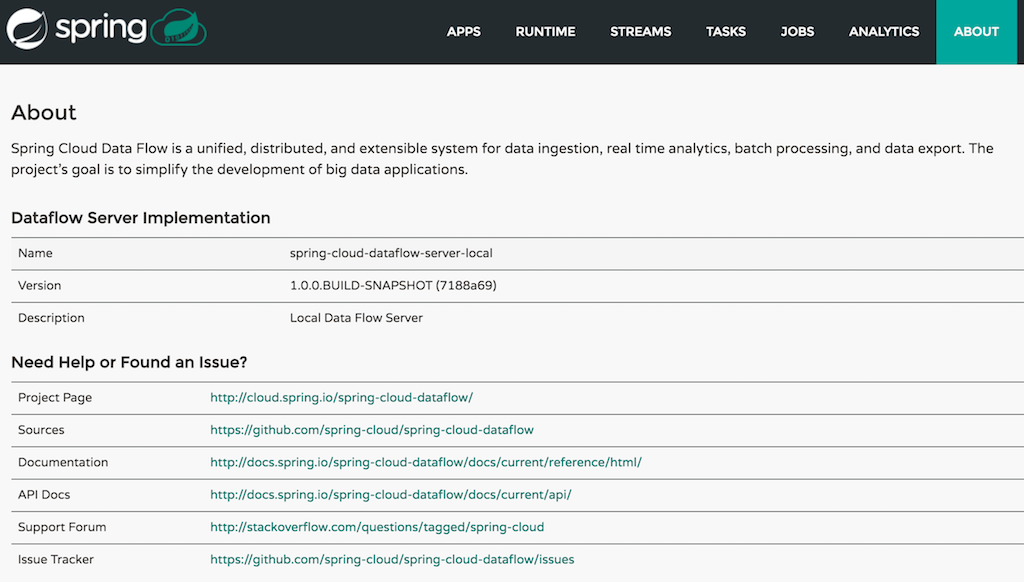

26.关于配置

Spring Cloud Data Flow关于Restful API结果包含显示名称,版本,以及(如果指定)包含Spring Cloud Data Flow的每个主要依赖项的URL。结果(如果已启用)还包含shell依赖项的sha1和/或sha256校验和值。通过设置以下属性,可以配置为每个依赖项返回的信息:

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-core.name:用于核心的名称。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-core.version:用于核心的版本。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-dashboard.name:用于仪表板的名称。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-dashboard.version:用于仪表板的版本。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-implementation.name:用于实现的名称。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-implementation.version:用于实现的版本。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.name:用于shell的名称。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.version:用于shell的版本。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.url:用于下载shell依赖项的URL。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.checksum-sha1:与shell依赖关系信息一起返回的sha1校验和值。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.checksum-sha256:与shell依赖关系信息一起返回的sha256校验和值。

-

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.checksum-sha1-url:如果未指定

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.checksum-sha1,SCDF将使用此URL指定的文件内容作为校验和。 -

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.checksum-sha256-url:如果未指定

spring.cloud.dataflow.version-info.spring-cloud-dataflow-shell.checksum-sha256,则SCDF使用此URL指定的文件内容作为校验和。

26.1.启用Shell Checksum值

默认情况下,不会显示shell依赖项的校验和值。如果需要启用此功能,请将spring.cloud.dataflow.version-info.dependency-fetch.enabled属性设置为true。

26.2.URL的保留值

您可以在URL中插入保留值(用花括号括起来),以确保链接是最新的:

-

存储库:如果使用数据流的构建快照,里程碑或候选发布版,则存储库引用repo-spring-io存储库。否则,它指的是Maven Central。

-

version:插入jar / pom的版本。

例如,如果您使用的是Spring Cloud Data Flow Shell的1.2.3.RELEASE版本,则myrepository/org/springframework/cloud/spring-cloud-dataflow-shell/{version}/spring-cloud-dataflow-shell-{version}.jar会生成myrepository/org/springframework/cloud/spring-cloud-dataflow-shell/1.2.3.RELEASE/spring-cloud-dataflow-shell-1.2.3.RELEASE.jar

Shell

本节介绍了启动shell的选项以及与shell如何处理SpEL表达式的空格,引号和解释相关的更高级功能。Stream DSL和Composed Task DSL的入门章节 是最常见的shell命令使用的好地方。

27. Shell选项

shell建立在Spring Shell项目之上。有Spring Shell通用的命令行选项和一些特定于数据流的命令行选项。shell采用以下命令行选项

unix:>java -jar spring-cloud-dataflow-shell-1.7.3.RELEASE.jar --help

Data Flow Options:

--dataflow.uri= Address of the Data Flow Server [default: http://localhost:9393].

--dataflow.username= Username of the Data Flow Server [no default].

--dataflow.password= Password of the Data Flow Server [no default].

--dataflow.credentials-provider-command= Accept any SSL certificate (even self-signed) [default: no].

--dataflow.proxy.uri= Address of an optional proxy server to use [no default].

--dataflow.proxy.username= Username of the proxy server (if required by proxy server) [no default].

--dataflow.proxy.password= Password of the proxy server (if required by proxy server) [no default].

--spring.shell.historySize= Default size of the shell log file [default: 3000].

--spring.shell.commandFile= Data Flow Shell executes commands read from the file(s) and then exits.

--help This message. spring.shell.commandFile选项可用于指向包含所有shell命令的现有文件,以部署一个或多个相关的流和任务。

还支持多个文件执行,它们应该以逗号分隔的字符串传递:

--spring.shell.commandFile=file1.txt,file2.txt

在创建一些脚本以帮助自动部署时,这非常有用。

此外,以下shell命令有助于将复杂脚本模块化为多个独立文件:

dataflow:>script --file <YOUR_AWESOME_SCRIPT>

28.列出可用命令

在命令提示符下键入help会列出所有可用命令。大多数命令都用于数据流功能,但有一些是通用的。

! - Allows execution of operating system (OS) commands

clear - Clears the console

cls - Clears the console

date - Displays the local date and time

exit - Exits the shell

http get - Make GET request to http endpoint

http post - POST data to http endpoint

quit - Exits the shell

system properties - Shows the shell's properties

version - Displays shell version将命令的名称添加到help会显示有关如何调用命令的其他信息。

dataflow:>help stream create

Keyword: stream create

Description: Create a new stream definition

Keyword: ** default **

Keyword: name

Help: the name to give to the stream

Mandatory: true

Default if specified: '__NULL__'

Default if unspecified: '__NULL__'

Keyword: definition

Help: a stream definition, using the DSL (e.g. "http --port=9000 | hdfs")

Mandatory: true

Default if specified: '__NULL__'

Default if unspecified: '__NULL__'

Keyword: deploy

Help: whether to deploy the stream immediately

Mandatory: false

Default if specified: 'true'

Default if unspecified: 'false'29.标签完成

通过在前导--后按TAB键,可以在shell中完成shell命令选项。例如,在stream create --之后按TAB会导致

dataflow:>stream create --

stream create --definition stream create --name如果您键入--de然后点击制表符,则会展开--definition。

对于应用程序或任务属性,还可以在流或组合任务DSL表达式中使用选项卡完成。您还可以使用TAB获取流DSL表达式中的提示,以获取可用的源,处理器或接收器。

30.白色空间和报价规则

如果参数值包含空格或|字符,则只需引用它们。以下示例将SpEL表达式(应用于它遇到的任何数据)传递给转换处理器:

transform --expression='new StringBuilder(payload).reverse()'

如果参数值需要嵌入单引号,请使用两个单引号,如下所示:

scan --query='Select * from /Customers where name=''Smith'''30.1.行情和逃避

有一个Spring基于Shell的客户端与数据流服务器通信,负责解析 DSL。反过来,应用程序可能具有依赖于嵌入式语言的应用程序属性,例如Spring表达式语言。

shell,Data Flow DSL解析器和SpEL有关于它们如何处理引号以及语法转义如何工作的规则。当组合在一起时,可能会出现混淆。本节介绍适用的规则,并提供在涉及所有三个组件时可能遇到的最复杂情况的示例。

|

它并不总是那么复杂

如果不使用数据流shell(例如,直接使用REST API)或者应用程序属性不是SpEL表达式,则转义规则更简单。 |

30.1.1.壳牌规则

可以说,引用时最复杂的组件是shell。但规则可以非常简单地列出:

-

shell命令由键(

--something)和相应的值组成。但是,有一种特殊的无键映射,稍后将对此进行描述。 -

值通常不能包含空格,因为空格是命令的默认分隔符。

-

通过用引号(单个(

')或双(")引号)包围值,可以添加空格。 -

不应再次引用在部署属性(例如

deployment <stream-name> --properties " …")内传递的值。 -

如果用引号括起来,则值可以通过在其前面添加反斜杠(

\)来嵌入相同类型的文字引号。 -

可以使用其他转义,例如

\t,\n,\r,\f和\uxxxx形式的unicode转义。 -

无密钥映射以特殊方式处理,因此它不需要引用来包含空格。

例如,shell支持!命令来执行本机shell命令。!接受单个无密钥参数。这就是以下工作的原因:

dataflow:>! rm something

这里的参数是整个rm something字符串,它按原样传递给底层shell。

作为另一个示例,以下命令严格等效,参数值为something(不带引号):

dataflow:>stream destroy something dataflow:>stream destroy --name something dataflow:>stream destroy "something" dataflow:>stream destroy --name "something"

30.1.2.属性文件规则

从文件加载属性时放宽规则。*需要转义属性文件(Java和YAML)中使用的特殊字符。例如\应替换为\\,'/ t`替换为\\t等等。*对于Java属性文件(--propertiesFile <FILE_PATH> .properties),属性值不应该用引号括起来!即使它们包含空格也不需要它。

filter.expression=payload > 5

-

但是,对于YAML属性文件(

--propertiesFile<FILE_PATH> .yaml),值必须用双引号括起来。

app:

filter:

filter:

expression: "payload > 5"

30.1.3.DSL解析规则

在解析器级别(即,在流或任务定义的主体内),规则如下:

-

通常会解析选项值,直到第一个空格字符。

-

它们可以由文字字符串组成,但用单引号或双引号括起来。

-

要嵌入这样的引用,请使用所需类型的两个连续引号。

因此,在以下示例中,过滤器应用程序的--expression选项的值在语义上是等效的:

filter --expression=payload>5 filter --expression="payload>5" filter --expression='payload>5' filter --expression='payload > 5'

可以说,最后一个更具可读性。这得益于周围的报价。实际表达式为payload > 5(不带引号)。

现在,假设我们想要测试字符串消息。如果我们想要将有效负载与SpEL文字字符串"something"进行比较,我们可以使用以下内容:

filter --expression=payload=='something' (1) filter --expression='payload == ''something''' (2) filter --expression='payload == "something"' (3)

| 1 | 这是有效的,因为没有空格。但是,它不是很清晰。 |

| 2 | 这使用单引号来保护整个参数。因此,实际的单引号需要加倍。 |

| 3 | SpEL使用单引号或双引号识别字符串文字,因此最后一种方法可以说是最具可读性的。 |

请注意,前面的示例将在shell之外考虑(例如,直接调用REST API时)。当在shell中输入时,很可能整个流定义本身都在双引号内,需要对其进行转义。然后整个例子变成如下:

dataflow:>stream create something --definition "http | filter --expression=payload='something' | log" dataflow:>stream create something --definition "http | filter --expression='payload == ''something''' | log" dataflow:>stream create something --definition "http | filter --expression='payload == \"something\"' | log"

30.1.4.SpEL语法和SpEL文字

拼图的最后一部分是关于SpEL表达式。许多应用程序接受将被解释为SpEL表达式的选项,并且如上所述,字符串文字也以特殊方式处理。规则如下:

-

文字可以用单引号或双引号括起来。

-

引号需要加倍才能嵌入字面引用。双引号内的单引号不需要特殊处理,反之亦然。

作为最后一个示例,假设您要使用转换处理器。此处理器接受expression选项,该选项是SpEL表达式。它将根据传入消息进行评估,默认值为payload(它不会触发消息有效负载)。

重要的是要理解以下陈述是等效的:

transform --expression=payload transform --expression='payload'

但是,它们与以下内容不同(以及它们的变体):

transform --expression="'payload'" transform --expression='''payload'''

第一个系列评估消息有效负载,而后面的示例评估为文字字符串payload,(同样,没有引号)。

30.1.5.把它放在一起

作为最后一个完整的示例,考虑如何通过在数据流shell的上下文中创建流来强制将所有消息转换为字符串文字hello world:

dataflow:>stream create something --definition "http | transform --expression='''hello world''' | log" (1) dataflow:>stream create something --definition "http | transform --expression='\"hello world\"' | log" (2) dataflow:>stream create something --definition "http | transform --expression=\"'hello world'\" | log" (2)

| 1 | 在第一行中,字符串周围有单引号(在数据流解析器级别),但它们需要加倍,因为它们在字符串文字内(由等号后面的第一个单引号启动)。 |

| 2 | 第二行和第三行分别使用单引号和双引号来包含数据流解析器级别的整个字符串。因此,可以在字符串内使用其他类型的引用。但是整个事情都在shell的--definition参数内,它使用双引号。因此,双引号被转义(在shell级别) |

流

本节详细介绍了如何创建Streams,它们是Spring Cloud Stream应用程序的集合 。它涵盖了创建和部署Streams等主题。

如果您刚开始使用Spring Cloud Data Flow,则在深入了解本节之前,您应该阅读“ 入门指南”。

31.简介

Stream是一组长期存在的Spring Cloud Stream应用程序,它们通过消息传递中间件相互通信。基于文本的DSL定义了应用程序之间的配置和数据流。虽然为您提供了许多应用程序来实现常见用例,但您通常会创建一个自定义Spring Cloud Stream应用程序来实现自定义业务逻辑。

Stream的一般生命周期是:

-

注册申请。

-

创建流定义。

-

部署流。

-

取消部署或销毁流。

-

流中的升级或Rollack应用程序。

如果使用Skipper,则可以在Stream中升级或回滚应用程序。

部署流有两种选择:

-

使用部署到单个平台的Data Flow Server实现。

-

配置数据流服务器以将部署委派给名为Skipper的Spring Cloud生态系统中的新服务器。

使用第一个选项时,您可以使用本地数据流服务器将流部署到本地计算机,Cloud Foundry的数据流服务器将流部署到Cloud Foundry上的单个组织和空间。同样,您可以使用Kuberenetes的数据流服务器将流部署到Kubernetes集群上的单个命名空间。有关数据流服务器实现的列表,请参见Spring Cloud Data Flow项目页面。

使用第二个选项时,您可以配置Skipper将应用程序部署到一个或多个Cloud Foundry组织和空间,Kubernetes集群上的一个或多个名称空间或本地计算机。使用Skipper在数据流中部署流时,您可以指定在部署时使用哪个平台。Skipper还为数据流提供了对已部署流进行更新的能力。可以通过多种方式更新流中的应用程序,但最常见的示例之一是使用新的自定义业务逻辑升级处理器应用程序,同时仅保留现有的源和接收器应用程序。

31.1.流管道DSL

使用基于unix的Pipeline语法定义流。语法使用竖线,也称为“管道”来连接多个命令。Unix中的命令ls -l | grep key | less获取ls -l进程的输出并将其传递给grep key进程的输入。grep的输出又被发送到less进程的输入。每个|符号将左侧命令的标准输出连接到右侧命令的标准输入。数据从左到右流过管道。

在数据流中,Unix命令由Spring Cloud Stream应用程序替换,每个管道符号表示通过消息中间件(例如RabbitMQ或Apache Kafka)连接应用程序的输入和输出。

每个Spring Cloud Stream应用程序都以简单名称注册。注册过程指定可以获取应用程序的位置(例如,在Maven Repository或Docker注册表中)。您可以在本节中找到有关如何注册Spring Cloud Stream应用程序的更多信息。在数据流中,我们将Spring Cloud Stream应用程序分类为源,处理器或接收器。

举一个简单的例子,考虑从HTTP Source写入文件接收器的数据集合。使用DSL,流描述是:

http | file

涉及某些处理的流将表示为:

http | filter | transform | file

可以使用shell的stream create命令创建流定义,如以下示例所示:

dataflow:> stream create --name httpIngest --definition "http | file"

Stream DSL传入--definition命令选项。

流定义的部署是通过shell的stream deploy命令完成的。

dataflow:> stream deploy --name ticktock

“ 入门”部分介绍了如何启动服务器以及如何启动和使用Spring Cloud Data Flow shell。

请注意,shell调用数据流服务器的REST API。有关直接向服务器发出HTTP请求的更多信息,请参阅REST API指南。

31.2.流应用程序DSL

上一节中描述的Stream Pipeline DSL自动设置每个Spring Cloud Stream应用程序的输入和输出绑定属性。这可以完成,因为Spring Cloud Stream应用程序中只有一个输入和/或输出目标,它使用Source,Processor或Sink提供的绑定接口。但是,Spring Cloud Stream应用程序可以定义自定义绑定接口,如下所示

public interface Barista {

@Input

SubscribableChannel orders();

@Output

MessageChannel hotDrinks();

@Output

MessageChannel coldDrinks();

}或者在创建Kafka Streams应用程序时很常见,

interface KStreamKTableBinding {

@Input

KStream<?, ?> inputStream();

@Input

KTable<?, ?> inputTable();

}在具有多个输入和输出绑定的这些情况下,数据流无法对从一个应用程序到另一个应用程序的数据流做出任何假设。因此,开发人员需要将绑定属性设置为“连接”应用程序。该流应用DSL使用double pipe,而不是pipe symbol,以表明数据流不应该配置应用程序的结合特性。将||视为'并行'的含义。例如:

dataflow:> stream create --definition "orderGeneratorApp || baristaApp || hotDrinkDeliveryApp || coldDrinkDeliveryApp" --name myCafeStream

打破变革!SCDF Local,Cloud Foundry 1.7.0到1.7.2和SCDF Kubernetes 1.7.0到1.7.1的版本使用comma字符作为应用程序之间的分隔符。这导致了传统Stream DSL的重大变化。虽然不理想,但改变分隔符特性被认为是对现有用户影响最小的最佳解决方案。

|

此流中有四个应用程序。baristaApp有两个输出目标,hotDrinks和coldDrinks分别由hotDrinkDeliveryApp和coldDrinkDeliveryApp使用。部署此流时,您需要设置绑定属性,以便baristaApp将热饮消息发送到hotDrinkDeliveryApp目的地,并将冷饮消息发送到coldDrinkDeliveryApp目的地。例如

app.baristaApp.spring.cloud.stream.bindings.hotDrinks.destination=hotDrinksDest

app.baristaApp.spring.cloud.stream.bindings.coldDrinks.destination=coldDrinksDest

app.hotDrinkDeliveryApp.spring.cloud.stream.bindings.input.destination=hotDrinksDest

app.coldDrinkDeliveryApp.spring.cloud.stream.bindings.input.destination=coldDrinksDest如果要使用使用者组,则需要分别在生产者和使用者应用程序上设置Spring Cloud Stream应用程序属性spring.cloud.stream.bindings.<channelName>.producer.requiredGroups和spring.cloud.stream.bindings.<channelName>.group。

Stream Application DSL的另一个常见用例是部署一个http网关应用程序,该应用程序向Kafka或RabbitMQ应用程序发送同步请求/回复消息。在这种情况下,http网关应用程序和Kafka或RabbitMQ应用程序都可以是不使用Spring Cloud Stream库的Spring Integration应用程序。

也可以使用Stream应用程序DSL部署单个应用程序。

31.3.应用属性

每个应用程序都使用属性来定制其行为。例如,http源模块公开port设置,允许从默认值更改数据提取端口。

dataflow:> stream create --definition "http --port=8090 | log" --name myhttpstream

此port属性实际上与标准Spring Boot server.port属性相同。数据流添加了使用简写形式port而不是server.port的功能。也可以指定longhand版本,如以下示例所示:

dataflow:> stream create --definition "http --server.port=8000 | log" --name myhttpstream

有关白名单应用程序属性的部分将更详细地讨论此简写行为。如果已注册应用程序属性元数据,则可以在键入--后使用shell中的选项卡完成来获取候选属性名称列表。

shell为应用程序属性提供了Tab键完成。shell命令app info --name <appName> --type <appType>为所有支持的属性提供了附加文档。

支持的流<appType>可能性包括:源,处理器和接收器。

|

32.流生命周期

在“经典”模式下,流的生命周期经历以下阶段:

32.1.注册流应用程序

您可以使用Spring Cloud Data Flow Shell app register命令在App Registry中注册Stream App。您必须提供唯一的名称,应用程序类型和可以解析为应用程序工件的URI。对于类型,请指定source,processor,sink或app。以下是source,processor和sink的一些示例:

dataflow:>app register --name mysource --type source --uri maven://com.example:mysource:0.0.1-SNAPSHOT

dataflow:>app register --name myprocessor --type processor --uri file:///Users/example/myprocessor-1.2.3.jar

dataflow:>app register --name mysink --type sink --uri http://example.com/mysink-2.0.1.jar提供带有maven方案的URI时,格式应符合以下条件:

maven://<groupId>:<artifactId>[:<extension>[:<classifier>]]:<version>例如,如果您要注册使用RabbitMQ绑定器构建的http和log应用程序的快照版本,则可以执行以下操作:

dataflow:>app register --name http --type source --uri maven://org.springframework.cloud.stream.app:http-source-rabbit:1.2.1.BUILD-SNAPSHOT

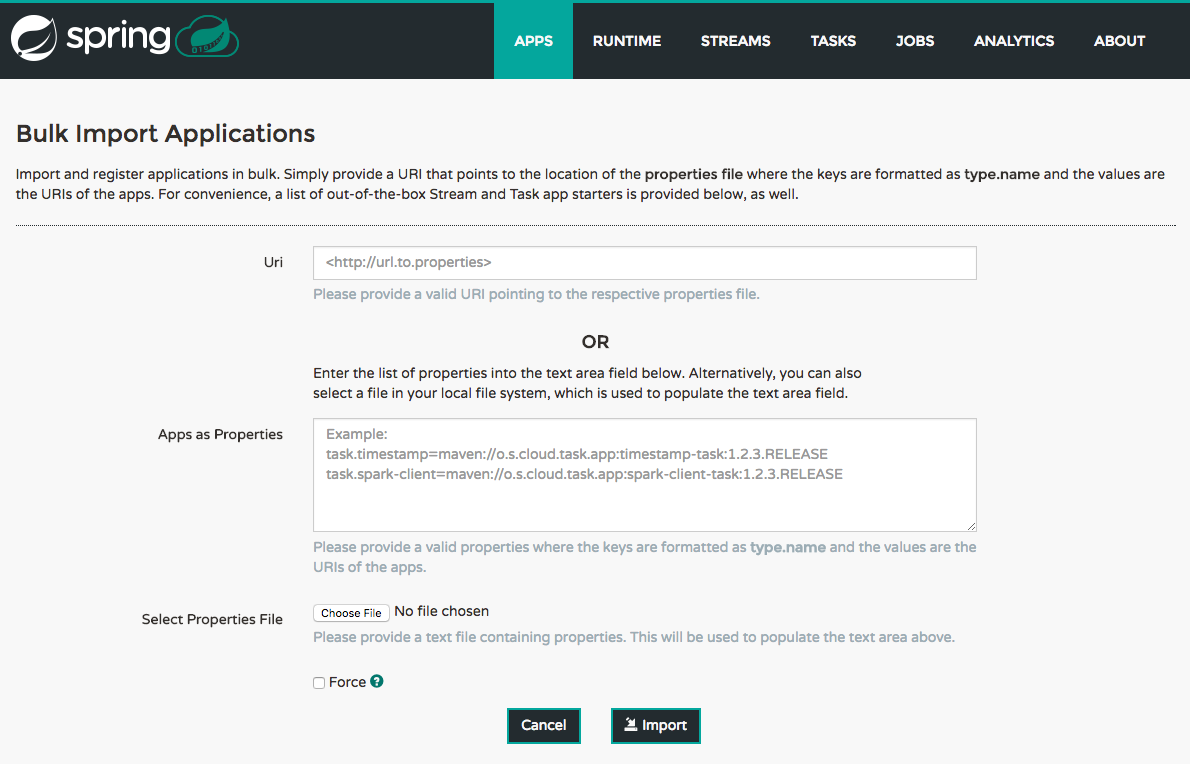

dataflow:>app register --name log --type sink --uri maven://org.springframework.cloud.stream.app:log-sink-rabbit:1.2.1.BUILD-SNAPSHOT如果您想一次注册多个应用程序,可以将它们存储在属性文件中,其中键的格式为<type>.<name>,值为URI。

例如,如果您要注册使用RabbitMQ绑定器构建的http和log应用程序的快照版本,则可以在属性文件中包含以下内容(例如,stream-apps.properties ):

source.http=maven://org.springframework.cloud.stream.app:http-source-rabbit:1.2.1.BUILD-SNAPSHOT

sink.log=maven://org.springframework.cloud.stream.app:log-sink-rabbit:1.2.1.BUILD-SNAPSHOT然后要批量导入应用程序,请使用app import命令并使用--uri开关提供属性文件的位置,如下所示:

dataflow:>app import --uri file:///<YOUR_FILE_LOCATION>/stream-apps.properties使用--type app注册应用程序与注册source,processor或sink相同。类型app的应用程序仅允许在Stream Application DSL中使用,它使用逗号而不是DSL中的管道符号,并指示数据流不配置应用程序的Spring Cloud Stream绑定属性。使用--type app注册的应用程序不必是Spring Cloud Stream应用程序,它可以是任何Spring Boot应用程序。有关使用此应用程序类型的更多信息,请参阅Stream Application DSL简介。

32.1.1.注册支持的应用和任务

为方便起见,我们为所有现成的流和任务/批处理应用程序启动程序提供了带有application-URI(适用于maven和docker)的静态文件。您可以指向此文件并批量导入所有应用程序URI。否则,如前所述,您可以单独注册它们,也可以拥有自己的自定义属性文件,其中只包含所需的应用程序URI。但是,建议在自定义属性文件中包含所需应用程序URI的“聚焦”列表。

下表列出了基于Spring Boot 1.5.x的可用流应用程序启动器的bit.ly链接:

| 神器类型 | 稳定释放 | SNAPSHOT发布 |

|---|---|---|

RabbitMQ + Maven |

bit.ly/Celsius-BUILD-SNAPSHOT-stream-applications-rabbit-maven |

|

RabbitMQ + Docker |

bit.ly/Celsius-BUILD-SNAPSHOT-stream-applications-rabbit-docker |

|

Kafka 0.10 + Maven |

bit.ly/Celsius-BUILD-SNAPSHOT-stream-applications-kafka-10-maven |

|

Kafka 0.10 + Docker |

bit.ly/Celsius-BUILD-SNAPSHOT-stream-applications-kafka-10-docker |

下表列出了基于Spring Boot 2.0.x的可用流应用程序启动器的bit.ly链接:

App Starter执行器端点默认是安全的。您可以通过使用属性app.*.spring.autoconfigure.exclude=org.springframework.boot.autoconfigure.security.servlet.SecurityAutoConfiguration部署流来禁用安全性。在Kubernetes上,请参阅Liveness和 readyiness 探针部分,以配置执行器端点的安全性。

|

| 神器类型 | 稳定释放 | SNAPSHOT发布 |

|---|---|---|

RabbitMQ + Maven |

bit.ly/Darwin-BUILD-SNAPSHOT-stream-applications-rabbit-maven |

|

RabbitMQ + Docker |

bit.ly/Darwin-BUILD-SNAPSHOT-stream-applications-rabbit-docker |

|

Kafka 0.11 and above + Maven |

bit.ly/Darwin-BUILD-SNAPSHOT-stream-applications-kafka-maven |

|

Kafka 0.11 and above + Docker |

bit.ly/Darwin-BUILD-SNAPSHOT-stream-applications-kafka-docker |

下表列出了可用的任务应用程序启动器:

| 神器类型 | 稳定释放 | SNAPSHOT发布 |

|---|---|---|

Maven |

||

Docker |

您可以在Task App Starters Project页面和相关参考文档中找到有关可用任务启动器的更多信息。有关可用流启动器的更多信息,请查看Stream App Starters项目页面 和相关参考文档。

例如,如果您想要批量注册使用Kafka活页夹构建的所有现成的流应用程序,可以使用以下命令:

$ dataflow:>app import --uri http://bit.ly/Darwin-SR3-stream-applications-kafka-maven或者,您可以使用Rabbit绑定器注册所有流应用程序,如下所示:

$ dataflow:>app import --uri http://bit.ly/Darwin-SR3-stream-applications-rabbit-maven您还可以传递--local选项(默认为true)以指示是否应在shell进程本身内解析属性文件位置。如果应从数据流服务器进程解析位置,请指定--local false。

|

使用 但是,请注意,一旦下载,应用程序可以根据资源位置在数据流服务器上本地缓存。如果资源位置没有改变(即使实际资源字节可能不同),则不会重新下载。另一方面,当使用 此外,如果已经部署了流并使用某个版本的已注册应用程序,那么(强制)重新注册其他应用程序将无效,直到再次部署该流。 |

| 在某些情况下,资源在服务器端解析。在其他情况下,URI将传递到解析它的运行时容器实例。有关更多详细信息,请参阅每个数据流服务器的特定文档。 |

32.1.2.白名单应用程序属性

流和任务应用程序是Spring Boot应用程序,它们知道许多Common Application Properties,例如server.port,但也有一些属性系列,例如前缀为spring.jmx和logging的属性。在创建自己的应用程序时,您应该将属性列入白名单,以便在通过TAB完成或在下拉框中显示选项时,shell和UI可以首先将它们显示为主要属性。

要将应用程序属性列入白名单,请在META-INF资源目录中创建名为spring-configuration-metadata-whitelist.properties的文件。可以在此文件中使用两个属性键。第一个键名为configuration-properties.classes。该值是以逗号分隔的完全限定的@ConfigurationProperty类名列表。第二个键是configuration-properties.names,其值是以逗号分隔的属性名称列表。这可以包含属性的全名,例如server.port,或部分名称,以将属性名称列入白名单,例如spring.jmx。

该Spring Cloud Stream应用程序启动器是寻找使用示例的好地方。以下示例来自文件接收器的spring-configuration-metadata-whitelist.properties文件:

configuration-properties.classes=org.springframework.cloud.stream.app.file.sink.FileSinkProperties如果我们还要将server.port添加为白名单,它将成为以下行:

configuration-properties.classes=org.springframework.cloud.stream.app.file.sink.FileSinkProperties

configuration-properties.names=server.port|

确保添加“spring-boot-configuration-processor”作为可选依赖项,以生成属性的配置元数据文件。 |

32.1.3.创建和使用专用元数据工件

通过创建元数据伴随工件,您可以更进一步描述流或任务应用程序支持的主要属性。此jar文件仅包含有关配置属性元数据的Spring引导JSON文件和上一节中描述的白名单文件。

以下示例显示了规范log接收器的此类工件的内容:

$ jar tvf log-sink-rabbit-1.2.1.BUILD-SNAPSHOT-metadata.jar

373848 META-INF/spring-configuration-metadata.json

174 META-INF/spring-configuration-metadata-whitelist.properties请注意,spring-configuration-metadata.json文件非常大。这是因为它包含运行时可用于log接收器的所有属性的串联(其中一些来自spring-boot-actuator.jar,其中一些来自spring-boot-autoconfigure.jar,更多来自spring-cloud-starter-stream-sink-log.jar }, 等等)。数据流总是依赖于所有这些属性,即使伴随工件不可用,但这里所有属性都已合并到一个文件中。

为了帮助你(你不想尝试手工制作这个巨大的JSON文件),你可以在你的构建中使用以下插件:

<plugin>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-app-starter-metadata-maven-plugin</artifactId>

<executions>

<execution>

<id>aggregate-metadata</id>

<phase>compile</phase>

<goals>

<goal>aggregate-metadata</goal>

</goals>

</execution>

</executions>

</plugin>

此插件除了创建单个JSON文件的spring-boot-configuration-processor之外。一定要配置两者。

|

配套工件的好处包括:

-

更轻松。(伴随工件通常为几千字节,而不是实际应用程序的兆字节。)因此,它们下载速度更快,允许在使用时提供更快的反馈,例如

app info或仪表板UI。 -

由于更轻,因此当元数据是所需的唯一信息时,它们可用于资源受限的环境(例如PaaS)。

-

对于不直接处理Spring Boot uber jar的环境(例如,基于Docker的运行时,如Kubernetes或Cloud Foundry),这是提供有关应用程序支持的属性的元数据的唯一方法。

但请记住,在处理超级罐时,这完全是可选的。超级jar本身也包含其中的元数据。

32.1.4.使用Companion Artifact

一旦掌握了伴随工件,就需要让系统了解它,以便可以使用它。

使用app register注册单个应用程序时,可以在shell中使用可选的--metadata-uri选项,如下所示:

dataflow:>app register --name log --type sink

--uri maven://org.springframework.cloud.stream.app:log-sink-kafka-10:1.2.1.BUILD-SNAPSHOT

--metadata-uri maven://org.springframework.cloud.stream.app:log-sink-kafka-10:jar:metadata:1.2.1.BUILD-SNAPSHOT使用app import命令注册多个文件时,除了每个<type>.<name>行之外,该文件还应包含<type>.<name>.metadata行。严格来说,这样做是可选的(如果有些应用程序有,但有些应用程序没有,它可以工作),但这是最好的做法。

以下示例显示了一个Dockerized应用程序,其中元数据工件托管在Maven存储库中(通过http://或file://检索它同样可行)。

...

source.http=docker:springcloudstream/http-source-rabbit:latest

source.http.metadata=maven://org.springframework.cloud.stream.app:http-source-rabbit:jar:metadata:1.2.1.BUILD-SNAPSHOT

...32.1.5.创建定制应用程序

虽然可以使用开箱即用的源,处理器,接收器应用程序,但您可以扩展这些应用程序或编写自定义Spring Cloud Stream应用程序。

使用Spring Initializr创建Spring Cloud Stream应用程序的过程在Spring Cloud Stream 文档中有详细说明。可以将多个绑定器包括到应用程序中。如果这样做,请参阅传递Spring Cloud Stream属性中的说明以了解如何配置它们。

为了支持属性白名单,在Spring Cloud Data Flow中运行的Spring Cloud Stream应用程序可能包含Spring Boot configuration-processor作为可选依赖项,如以下示例所示:

<dependencies>

<!-- other dependencies -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-configuration-processor</artifactId>

<optional>true</optional>

</dependency>

</dependencies>|

确保POM中包含 |

32.2.创建流

Spring Cloud Data Flow服务器公开了一个完整的RESTful API来管理流定义的生命周期,但最简单的方法是通过Spring Cloud Data Flow shell。按照“ 入门”部分中的说明启动shell 。

在流定义的帮助下创建新流。定义是从简单的DSL构建的。例如,考虑如果我们执行以下shell命令会发生什么:

dataflow:> stream create --definition "time | log" --name ticktock这定义了一个名为ticktock的流,它基于DSL表达式time | log。DSL使用“管道”符号(|)将源连接到接收器。

32.2.1.申请Properties

应用程序属性是与流中的每个应用程序关联的属性。部署应用程序时,应用程序属性将通过命令行参数或环境变量应用于应用程序,具体取决于基础部署实现。

以下流可以在创建流时定义应用程序属性:

dataflow:> stream create --definition "time | log" --name ticktock以下清单显示了time应用的white_listed属性:

dataflow:> app info --name time --type source

╔══════════════════════════════╤══════════════════════════════╤══════════════════════════════╤══════════════════════════════╗

║ Option Name │ Description │ Default │ Type ║

╠══════════════════════════════╪══════════════════════════════╪══════════════════════════════╪══════════════════════════════╣

║trigger.time-unit │The TimeUnit to apply to delay│<none> │java.util.concurrent.TimeUnit ║

║ │values. │ │ ║

║trigger.fixed-delay │Fixed delay for periodic │1 │java.lang.Integer ║

║ │triggers. │ │ ║

║trigger.cron │Cron expression value for the │<none> │java.lang.String ║

║ │Cron Trigger. │ │ ║

║trigger.initial-delay │Initial delay for periodic │0 │java.lang.Integer ║

║ │triggers. │ │ ║

║trigger.max-messages │Maximum messages per poll, -1 │1 │java.lang.Long ║

║ │means infinity. │ │ ║

║trigger.date-format │Format for the date value. │<none> │java.lang.String ║

╚══════════════════════════════╧══════════════════════════════╧══════════════════════════════╧══════════════════════════════╝以下清单显示了log应用的白名单属性:

dataflow:> app info --name log --type sink

╔══════════════════════════════╤══════════════════════════════╤══════════════════════════════╤══════════════════════════════╗

║ Option Name │ Description │ Default │ Type ║

╠══════════════════════════════╪══════════════════════════════╪══════════════════════════════╪══════════════════════════════╣

║log.name │The name of the logger to use.│<none> │java.lang.String ║

║log.level │The level at which to log │<none> │org.springframework.integratio║

║ │messages. │ │n.handler.LoggingHandler$Level║

║log.expression │A SpEL expression (against the│payload │java.lang.String ║

║ │incoming message) to evaluate │ │ ║

║ │as the logged message. │ │ ║

╚══════════════════════════════╧══════════════════════════════╧══════════════════════════════╧══════════════════════════════╝time和log应用程序的应用程序属性可以在创建stream时指定,如下所示:

dataflow:> stream create --definition "time --fixed-delay=5 | log --level=WARN" --name ticktock请注意,在前面的示例中,为应用time和log定义的fixed-delay和level属性是shell完成提供的“'short-form'”属性名称。这些“'短格式'”属性名称仅适用于列入白名单的属性。在所有其他情况下,只应使用完全限定的属性名称。

32.2.2.共同申请Properties

除了通过DSL进行配置之外,Spring Cloud Data Flow还提供了一种机制,用于为其启动的所有流应用程序设置公共属性。这可以通过在启动服务器时添加前缀为spring.cloud.dataflow.applicationProperties.stream的属性来完成。执行此操作时,服务器将所有不带前缀的属性传递给它启动的实例。

例如,通过使用以下选项启动数据流服务器,可以将所有已启动的应用程序配置为使用特定的Kafka代理:

--spring.cloud.dataflow.applicationProperties.stream.spring.cloud.stream.kafka.binder.brokers=192.168.1.100:9092

--spring.cloud.dataflow.applicationProperties.stream.spring.cloud.stream.kafka.binder.zkNodes=192.168.1.100:2181这样做会导致属性spring.cloud.stream.kafka.binder.brokers和spring.cloud.stream.kafka.binder.zkNodes传递给所有已启动的应用程序。

使用此机制配置的Properties优先级低于流部署属性。如果在流部署时指定具有相同键的属性(例如,app.http.spring.cloud.stream.kafka.binder.brokers覆盖公共属性),则会覆盖它们。

|

32.3.部署流

本节介绍在Spring Cloud Data Flow服务器负责部署流时如何部署流。以下部分“ Stream Lifecycle with Skipper ”涵盖了Spring Cloud Data Flow服务器委派给Skipper进行流部署时的新部署和升级功能。部署属性如何应用于Stream部署的两种方法的描述。

给出ticktock流定义:

dataflow:> stream create --definition "time | log" --name ticktock

要部署流,请使用以下shell命令:

dataflow:> stream deploy --name ticktock

数据流服务器将time和log解析为maven坐标,并使用它们启动流的time和log应用程序,如下面的清单所示:

2016-06-01 09:41:21.728 INFO 79016 --- [nio-9393-exec-6] o.s.c.d.spi.local.LocalAppDeployer : deploying app ticktock.log instance 0

Logs will be in /var/folders/wn/8jxm_tbd1vj28c8vj37n900m0000gn/T/spring-cloud-dataflow-912434582726479179/ticktock-1464788481708/ticktock.log

2016-06-01 09:41:21.914 INFO 79016 --- [nio-9393-exec-6] o.s.c.d.spi.local.LocalAppDeployer : deploying app ticktock.time instance 0

Logs will be in /var/folders/wn/8jxm_tbd1vj28c8vj37n900m0000gn/T/spring-cloud-dataflow-912434582726479179/ticktock-1464788481910/ticktock.time在前面的示例中,时间源每秒将当前时间作为消息发送,并且日志接收器使用日志记录框架输出它。您可以尾随stdout日志(后缀为<instance>)。日志文件位于数据流服务器日志输出中显示的目录中,如下面的清单所示:

$ tail -f /var/folders/wn/8jxm_tbd1vj28c8vj37n900m0000gn/T/spring-cloud-dataflow-912434582726479179/ticktock-1464788481708/ticktock.log/stdout_0.log

2016-06-01 09:45:11.250 INFO 79194 --- [ kafka-binder-] log.sink : 06/01/16 09:45:11

2016-06-01 09:45:12.250 INFO 79194 --- [ kafka-binder-] log.sink : 06/01/16 09:45:12

2016-06-01 09:45:13.251 INFO 79194 --- [ kafka-binder-] log.sink : 06/01/16 09:45:13您还可以通过在创建流时传递--deploy标志来一步创建和部署流,如下所示:

dataflow:> stream create --definition "time | log" --name ticktock --deploy但是,在实际用例中,一步创建和部署流并不常见。原因是当您使用stream deploy命令时,您可以传入定义如何将应用程序映射到平台的属性(例如,要使用的容器的内存大小,每个应用程序的数量到运行,以及是否启用数据分区功能)。Properties还可以覆盖在创建流时设置的应用程序属性。接下来的部分将详细介绍此功能。

32.3.1.部署Properties

部署流时,您可以指定属于两个组的属性:

-

Properties控制应用程序如何部署到目标平台。这些属性使用

deployer前缀,称为deployer属性。 -

Properties设置应用程序属性或覆盖在流创建期间设置的应用程序属性,并称为

application属性。